Что такое SEO и как самостоятельно начать Сео оптимизацию и продвижение сайта

Здравствуйте, уважаемые читатели блога KtoNaNovenkogo.ru. Сегодня я хочу поговорить про то, что такое Seo, показать современные методы Сео оптимизации, которая способна буквально творить чудеса в продвижении сайта и ответить на вопрос, почему не стоит ни в коем случае пренебрегать Search Engine Optimization.

На самом деле, хоть эта статья и адресована в первую очередь начинающим вебмастерам, но по своему опыту могу судить, что многие состоявшиеся вебмастера Seo продвижением просто пренебрегают и даже не стараются понять его суть.

Есть очень избитая фраза, которая почему-то стала для многих догмой — пишите статьи для людей и успех не заставит себя ждать. Да, контент (содержимое) безусловно является основополагающим столпом успешного развития сайта, но далеко не единственным и уж никак не достаточным.

Seo — что это такое

Если говорить максимально простыми словами, то:

SEO — это любые действия, направленные на вывод вашего сайта или любого другого вашего ресурса в топовые позиции поисковиков для привлечение посетителей.

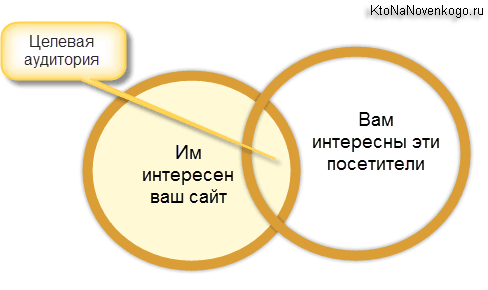

SEO — это аббревиатура от Search Engine Optimization, что можно перевести как «оптимизация под поисковые движки» или «поисковая оптимизация». Т.е. сюда относятся любые способы улучшения позиций вашего сайта в выдачах поисковых систем по нужным вам запросам. Это влечет к увеличению целевого трафика (потока посетителей) на ваш сайта с поисковиков.

Теперь дадим более научно определение термину:

Поисковая оптимизация (SEO) — это комплекс мер по внутренней и внешней оптимизации для поднятия позиций сайта в результатах выдачи поисковых систем по определённым запросам пользователей, с целью увеличения сетевого трафика (для информационных ресурсов) и потенциальных клиентов (для коммерческих ресурсов) и последующей монетизации (получение дохода) этого трафика.

Этой статьей я хочу приоткрыть вам глаза на реальное положение дел (как его вижу я) и попробовать переманить вас на «темную сторону силы» (ведь Seo это не совсем и не всегда белые методы). Вообще заниматься оптимизацией, как внутренней, так и внешней, нужно обязательно с четким понимание того, что именно вы делаете и к чему это может привести. Уже страшно? Хочется все бросить и сказать: «ну его на фиг, пусть все идет как шло»? Тоже выход, но не лучший.

Начнем с каменного века. Интернет формировался как большая помойка, где наряду с алмазами соседствовали огромные массы гумна. Собственно, он и до сих пор таким остается. Главная проблема как пользователя, так и вебмастера создавшего качественный ресурс, это найти друг друга.

Решение есть и его предложили разработчики поисковых систем (читайте о том, как работают поисковики). Они создали площадки (нечто похожее на биржи), где пользователь мог найти ресурсы отвечающие на заданный им вопрос. Но это решение имеет некоторое ограничение. Реальные шансы на переходы из поисковой выдачи имеют только те ресурсы, которые смогли попасть на ее первую страницу (так называемый Топ 10). А это означает, что рано или поздно за место в Топ 10 начнется грызня и эта грызня началась.

SEO — это, по большому счету, искусство попадания на первую страницу выдачи Яндекса или Гугла по интересующему вас поисковому запросу.

Поисковики до сих пор не могут предложить какое-нибудь решение, позволяющее сайтам, находящимся в выдаче существенно ниже 10 позиции, получать хотя бы капелюшечку от числа тех посетителей, которые вводят в поисковике интересующий их вопрос.

Фактически получается, что жизни за Топ 10 нет. Поэтому драка идет не шуточная и любые методы Сео оптимизации, способные перетянуть чащу весов в свою сторону, используются обязательно. Вообще ситуация очень похожа на то, как это было изображено на заглавной картинке в статье про ранжирование и релевантность сайтов в поисковой выдаче:

Но ведь Сео это не только технология, но еще и огромный бизнес.

Знаете сколько заработают ведущие компании из этой отрасли? В сумме, думаю, сотни миллионов долларов, что вполне сравнимо с доходами Яндекса. Как, вы не знали, что поисковики это сверхдоходные и сверхприбыльные предприятия? Ну, вот теперь знайте. Зарабатывают поисковые системы Гугл и Яндекс на показе контекстной рекламы (Директ и Адвордс).

А кто заказывает у поисковиков рекламу? В большинстве своем владельцы коммерческих ресурсов для привлечения к себе посетителей. И вся фишка в том, что оба эти бизнеса (контекстная реклама и оказание услуг Сео продвижения) являются по отношению друг к другу конкурентными.

Т.е. вы должны понимать, что Seo реально работает и не использовать его было бы большой оплошностью. Ваши потенциальные читатели, которые не смогут найти ваш замечательный сайт через Яндекс или Гугл, вам этого не простят.

Мало создать хороший проект с уникальным и нужным контентом, его обязательно нужно продвинуть в Топ 10 хотя бы по ряду не очень частотных запросов, чтобы начать привлекать к себе внимание читателей.

Легко ли сейчас быть Сео-шником

Сейчас работать в области SEO может далеко не каждый человек. Тут нужен особый склад характера, ибо существует целый ряд проблем, с которыми постоянно сталкивается подобный специалист:

- Работать приходится в условиях постоянно (перманентно) изменяющихся алгоритмов работы поисковых систем. Базовые принципы, описанные в приведенной по ссылке статье, остаются постоянными, однако меняются нюансы, которые оказывают существенное влияние на успех кампании по продвижению сайта. По сути, любые ранее обнаруженные Сеошниками закономерности могут перестать работать в одночасье, и никто не может гарантировать работоспособность используемых сейчас методов. Люди, любящие стабильность и определенность, на такой работе не приживутся.

- Будучи SEO специалистом вы можете не спать ночами, думать, делать, и в течении полугода буквально «жить» проектом заказчика, но в результате дела у продвигаемого сайта могут даже ухудшиться. Одновременно кто-то может палец о палец не ударить, а продвигаемый им проект будет расти в выдаче. Отсюда следует достаточно низкая мотивация Сеошников к свершению трудового подвига. Многое просто не в их власти, и успех зачастую может определить что-то, что воле сеошника не подвластно.

- Мало того, что результат в SEO по большому счету не гарантирован, так еще и действительно грамотных (опытных) специалистов в этой области довольно-таки мало, и уж точно меньше, чем это востребовано рынком. Поэтому средняя квалификация среднего сеошника довольно низкая. По сути, нет институтов или академий, которые бы их готовили. Или, во всяком случае, в достаточном количестве и надлежащего качества. Люди учатся по курсам, уже не актуальным книгам, статьям и блогам.

- Процессу повышения образованности сеошников прежде всего препятствует то, что предмет их изучения не хочет, чтобы они его изучали и узнавали. Поисковые системы ни в коей мере не заинтересованы в открытом диалоге с SEO специалистами, ибо, по сути, находятся с ними по разные стороны баррикад. Поэтому знания приходится получать путем наблюдения за поисковыми машинами и постановкой экспериментов, что не является самым простым и эффективным способом. Между собой сеошники тоже не так уж и охотно делятся своими наработками.

- Не все сайты предлагаемые заказчиками можно продвинуть средствами SEO в современных условиях. Они могли быть разработаны либо очень давно, либо без учета их возможного продвижения в поисковых системах.

- Зачастую владельцы сайтов сами не знают чего хотят, и сформулированные ими в задачах цели продвижения совершенно не соответствуют тому, что они на самом деле хотят получить в результате работы Сео специалиста. Возникают непонятки, но клиент, как всегда, прав и...

Под какой поисковик продвигаться?

Кроме всех описанных выше сложностей, Сео-шники вынуждены при продвижении сайтов пытаться «услужить» по крайней мере двум хозяевам — Яндексу и Гуглу. А если брать в расчет и поиск Mail.ru, то трем.

Если верить показаниям счетчика Ливинтернет, то в рунете (доменной зоне RU) сейчас наблюдается примерный паритет между Яндексом и Гуглом, а доля остальных поисковых систем исчезающе мала на их фоне (разве что только за исключение Майла, но там особая аудитория, которая в основном состоит из пользователей других сервисов этой корпорации).

Гул здорово подрос за последние годы, ибо раньше перевес у Яндекса был чуть ли не двухкратный. Секрет кроется в том, что сейчас идет тенденция к увеличению доли мобильного трафика (посетителей, заходящих на сайты со смартфонов и планшетов), а у Google тут огромное преимущество в виде собственной мобильной платформы Андроид и предустановленным там по умолчанию их поиском. Ход конем, что называется.

Как видно из данных того же Лайвинтернета, трафик с Андроида составляет больше трети от всего трафика рунета. Вы только вдумайтесь? А если брать в расчет и другие мобильные платформы, то число людей заходящих в сеть с мобильника уже превысило число тех, кто заходит с ПК или ноутбука. Дальше будет еще больший уход в мобильность и это опять же добавляет новых проблем сеошникам и маркетолагам, ибо существенно меняется поведение пользователей на сайте.

По-любому, от продвижения в Google (а уже тем более в Яндексе, ибо именно там сидит большая часть целевой аудитории по многим коммерческим тематикам) никто просто так отказаться не может, и практически все коммерческие сайты сейчас продвигаются под оба этих поисковика.

Ну, а если сайт будет ориентирован на буржунет, то там уже у Гугла вообще практически нет достойных конкурентов. На мировом уровне они даже не сопоставимы. Людские, финансовые и аппаратные ресурсы отличаются на порядок. А это влияет на то, как работают алгоритмы Google, и на то, как быстро он работает в целом.

Кроме этого, если опять вернуться к рунету, у Яндекса и Гугла существенно отличаются аудитории. Может вполне оказаться так, что вся ваша целевая аудитория пользуется только Гуглом (или только Яндексом).

Скажем так, в Яндексе больше чайников. И это вовсе не плохо, ибо из них получаются отличные покупатели, но если ваш товар или услуга ориентирована на чуть более продвинутых пользователей, то Google может стать для вас основным источником трафика. Какие-то глобальные исследования на этот счет вы вряд ли найдете в паблике, но я думаю, что начав развивать и продвигать сайт, вы быстро поймете, какая поисковая машина для вас является приоритетной.

Если говорить про поиск Майл.ру, то его доля в рунете составляет где-то около пяти процентов и обусловлена она прежде всего тем, что все сервисы Майла собирают огромную аудиторию в рунете (даже большую, чем все сервисы Яндекса). При этом у них периодически меняется поисковый движок. Они постоянно торгуются с Яндексом и Google о предоставлении им лучших условий, а когда договориться не удается, то временно используют свой собственный движок gogo.ru.

Белое, серое и черное SEO

Итак, SEO специалист должен будет всеми правдами и неправдами заставить упомянутые выше поисковые системы обратить внимание на продвигаемый им сайт (хотя бы в плане его полной индексации) и каким-то хитрым и непонятным способом принудить их его полюбить. И это все при том, что поисковики в своих лицензиях четко говорят, что при ранжировании и определении релевантности документов ими будут учитываться исключительно интересы пользователей поиска, а отнюдь не владельцев ресурсов.

Значит придется «хитрить» и зачастую идти на сознательное нарушение всех этих лицензий. В зависимости от степени ухищрений и глубины нарушений правил поисковых систем SEO продвижение можно разделить на три группы:

- Белая SEO оптимизация — все предпринимаемые действия будут идти в полном согласии с лицензиями поисковиков. Этот путь сложен, трудоемок, с низкой и сильно оттянутой по времени отдачей. Но в то же время он самый надежный, стабильный и за его использование не последует пессимизация, фильтры или бан.

- Прогнозирование запросов, по которым пользователи Яндекса или Гугла могут попасть на ваш сайт. Фактически это сборка семантического ядра с помощью, например, подбора ключевых слов в Вордстате и создания страниц под них оптимизированных. Поисковые системы это приветствуют, ибо им потом проще будет искать релевантную запросу информацию. Но тут, естественно, не идет речь о переоптимизации, ибо это уже является нарушением лицензии.

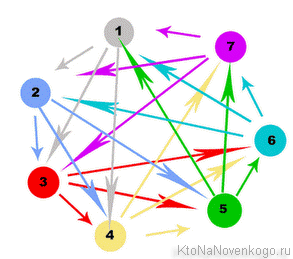

- Оптимизация структуры контента и его внутренней перелинковки. Поисковики опять же не будут возражать, если вы таким образом поможете их роботам быстрее найти и правильно обработать имеющийся контент. А также показать степень важности тех или иных материалов на вашем сайте. Но опять же без фанатизма.

- Естественное наращивание ссылочной массы. Ключевое слово здесь «естественное», но об этом мы поговорим чуть позже.

- Серое SEO — не совсем согласуется с лицензиями поисковых систем, но именно этот способ оптимизации является наиболее популярным и массовым среди Сеошников. Однако, это может быть воспринято, как попытки манипуляции выдачей, и на ваш сайт могут быть наложены санкции (фильтры).

- Покупка и обмен ссылками в больших масштабах

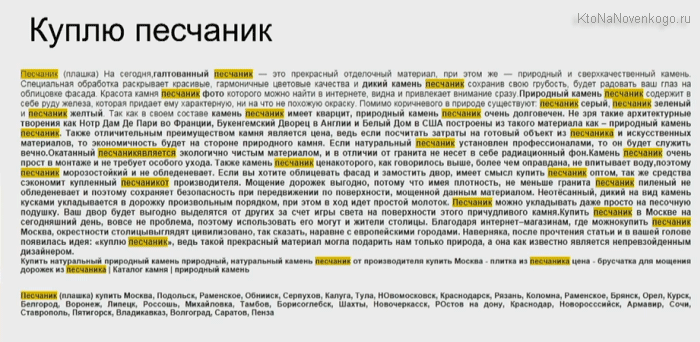

- Переоптимизация текстов (спам ключевыми словами) для повышения их релевантности в глазах поисковых систем

- Черная оптимизация — откровенное нарушение лицензии поисковиков, за что гарантированно можно получить наложение санкций (вопрос только в сроках, в течении которых вас обнаружат и прижучат).

Однако, эти методы по-прежнему используются, и в выдаче Яндекса и Гугла можно по некоторым запросам наблюдать, например, засилье дорвеев, а в индексе поиска все так же имеется огромное количество ГС (смотрите непонятные вам термины в статье про то, как начать понимать Сеошников).

Перечислю примеры черного SEO без вдавания в конкретику, ибо никогда этим не занимался и заниматься не намерен:

- ГС и Дорвеи — создаваемые вручную или автоматически «плохие» сайты, которые призваны обманывать поисковики (попадать в индекс, чтобы с них можно было продавать ссылки, или даже в Топ выдачи, чтобы на них шел трафик, который потом будет перепродаваться), но никакой полезности для посетителей не имеющие.

- Клоакинг

- Скрытый (невидимый) текст

- Что-то еще, о чем можно прочитать в лицензиях (см. лицензию Яндекса для примера).

Что нужно знать про работу поисковых систем

Однако для того, чтобы применять озвученные способы оптимизации, сеошник должен прежде всего понимать хотя бы общие принципы работы поисковых машин. И чем более рискованным SEO он собирается заниматься, тем более глубокими и детальными должны быть его познания.

Индексация сайтов

Работу начинает поисковый робот (бот), который представляет из себя обычный компьютер (сервер) с соответствующим ПО. Он обходит страницы с потенциальным наличием качественного и уникального контента, находит вебстраницу, определяет ее содержимое (объем, качество), и если она ему понравится, то он передает ее на следующий уровень, который можно определить, как поисковик.

В силу аппаратных ограничений роботы не снуют в интернете как заведенные, а руководствуются определенными принципами. Во-первых, они ходят на страницы, на которые проставлено много ссылок со страниц, которые уже есть в индексной базе. Во-вторых, частота повторного посещения не всегда высока и рассчитывается индивидуально.

У Яндекса можно выделить два типа роботов:

- Основной робот — индексация основного контента, не имеющего новостного характера, когда нужно будет быстро добавить его в выдачу. Тут ранжирование идет по полному циклу, в отличии от описанного ниже быстробота.

- Быстробот — поисковый робот, который призван наполнять выдачу наисвежайшими материалами. Он посещает сайты, где часто появляется новая информации (например, блоги с RSS лентой или новостные ресурсы). Найденные им страницы ранжируются, опираясь лишь на некоторые внутренние факторы, и они мгновенно появляются в выдаче с указанием даты их создания. Но на следующий день позиции по этим запросам могут измениться после прихода основного робота индексатора.

Поиск нужной информации в индексе

Поисковик представляет из себя опять же обычный сервер (что такое сервер), но с уже другим программным обеспечением. В его задачу входит обход найденных ботом страниц, скачивание их содержимого и дальнейшая его обработка (создание индекса).

Все помеченные поисковым роботом страницы выкачиваются (в виде исходных Html кодов), из них извлекается контент (текст заключенный в Html коде, который должен видеть посетитель) и производится его первичный разбор и анализ. Текст вебстраницы записывается в отдельный файл (условно) и туда же записываются все ссылки, найденные на странице (они потом отправляются поисковому роботу, чтобы он туда сходил тоже).

Из полученного текста удаляются все стоп-слова (союзы, предлоги) и знаки препинания. Полученный в результате набор слов разбивают на так называемые пассажи. По сути, это предложения, но с некоторыми допущениями. Пассажи, как и предложения, объединяются смысловой законченностью, но оперировать именно предложениями, при машинном анализе русского текста, практически не возможно (в силу его «великости и могучести»).

Т.е. анализ ведется не по физическим (изначально имеющимся в тексте) предложениям, а по вновь созданным (машинным), которые и назвали пассажами. Ну, а эти самые пассажи уже складываются в индексную базу и каждому пассажу присваивается свой вес, характеризующий его значимость внутри этого текста. Отчего может зависеть вес? Например, от того, насколько пассаж релевантен данному тексту, сколько раз он в нем повторяется и где внутри текста он расположен.

В результате формируется база данных (поисковый индекс), в которой каждая проиндексированная вебстраница представлена набором пассажей с удаленными шумовыми словами (бессмысленными, связующими, паразитными, повторениями). Именно по этой базе (индексу) ведется поиск.

Когда вам нужно будет вогнать в индекс новые страницы, появившиеся на сайте, то лучшим вариантом будут сервисы по привлечению быстробота (индексатора) поисковых систем. Среди них могу выделить два похожих — IndexGator и GetBot. Стоит это дело совсем не дорого, а эффект достаточно стабилен.

Определение релевантности и ранжирование результатов

На самом верхнем (к пользователям поисковых систем) находится поисковый сервис, который принимает запросы от пользователей, и на основании расчета релевантности и применения факторов ранжирования выбирает (из созданного на предыдущем этапе поисковиком обратного индекса) нужные вебстранички, которые потом и будут показаны пользователю в качестве выдачи (серпа).

Упрощенно это можно представить так, что посетитель Яндекса задает свой вопрос и поисковая система начинает искать в своей индексной базе страницы содержащие пассажи, максимально соответствующие этому запросу. Полученный список релевантных страниц теперь нужно будет ранжировать (расставить приоритеты), т.е. определить последовательность расположения этих вебстраниц в выдаче.

Первый принцип, который начал использоваться уже очень давно, называется индексом цитирования. В его базовой версии он учитывал число упоминаний данной страницы (число ведущих на нее ссылок). Об этой системе я довольно подробно писал в статье про то, что такое Тиц и Виц сайта в Яндексе. Недостаток такого подхода состоит в том, что учитывается только общее количество ссылок, но не их качество.

Поэтому далее был придуман взвешенный индекс цитирования, который учитывает авторитет и качество ссылающихся сайтов. Появляются так называемые веса (статические), которые передаются по ссылкам. В Google это индекс называется Пейдж Ранком, тулбарное значение которого раньше можно было узнать для любой страницы любого сайта (сейчас это дело прикрыли).

Взвешенный индекс цитирования можно описать, как коэффициент вероятности попадания посетителя на данную вебстраницу с любой другой страницы сети интернет. Другими словами, чем больше на эту страницу ссылок и чем больше среди ссылающихся ресурсов будет авторитетных, тем вероятнее будет посещение данной страницы и тем выше будет ее вес. Рассчитывается он с помощью формулы в несколько итераций. Формула эта периодически изменяется и дорабатывается.

Раньше мы могли наблюдать тулбарное значение ПейджРанка, которое обновлялось раз в несколько месяцев и было построено на основе логарифмической шкалы, когда реальная разница между весом страницы с ПР=1 и ПР=7 могла быть тысячекратной или даже больше. Подробности читайте в упомянутой чуть выше статье.

Также следует понимать, что то или иное значение ПейдРанка для вашей страницы на ее позицию в выдаче по тому или иному поисковому запросу прямого влияния оказывать не будет. Но в то же время алгоритм, заложенный в расчете ПР, используется при ранжировании страниц, а значит его нужно знать и понимать, чтобы в дальнейшем использовать для своей пользы.

Учет трансляции ссылочных весов при ранжировании

В схеме ПейджРанка (взвешенного индекса цитирования) имеется такое понятие, как передаваемый по ссылке вес.

Статический вес передаваемый по ссылкам

Передача веса является не совсем правильным термином, ибо вес не передается, а транслируется, т.е. донор (читайте статью про SEO термины) ничего не теряет при установке ссылки, но при этом акцептор получает по ней определенный статический вес. Под термином статический следует понимать то, что этот вес не зависит от того, что используется в качестве анкора ссылки.

Сколько веса может передать та или иная вебстраница в интернете могут знать только алгоритмы поисковиков. Но доподлинно известно, что этот самый вес будет поровну поделен между всеми страницами-акцепторами, на который будут вести ссылки с этого донора. Исходя из этого принципа можно сделать массу выводов по внешней и внутренней перелинковки своего сайта.

Общий вывод по принципу трансляции весов — для того, чтобы прокачать какую-либо свою страницу, нужно получать на нее ссылки, желательно с авторитетных страниц. А как узнать, высок ли авторитет той или иной страницы в интернете? Правильно, нужно посмотреть на значение ПейджРанка для нее.

У Яндекса тоже имеется аналог пейджранка, который рассчитывается для всех страниц (ВИЦ), но узнать его значение сейчас не представляется возможным. Также у нашего поисковика имеется в арсенале еще и тематический индекс цитирования Тиц, при расчете которого прежде всего учитывается тематика ссылающихся ресурсов.

Измеряется он для всего сайта целиком. Для тематических ссылок (оценивается тематика по содержанию текста) применяется повышающий коэффициент, по сравнению с околотематическими и нетематическими, для которых может применяться серьезная сбавка передаваемого веса. Поэтому для наращивания Тиц важны ссылки не просто с авторитетных ресурсов, а желательно, чтобы они были близкой или совпадающей тематики с вашим сайтом. Напрямую на ранжирование он не влияет, но те же принципы используются для построения сайтов в выдаче.

Что такое PageRank, в чем он измеряется и как формируется

По сути он является своеобразным мерилом (критерием ценности) той или иной странички в интернете. Его значение зависит от количества и качества обратных ссылок, ведущих с других страниц на данный документ. Чем больше ссылок — тем выше будет значение ПР.

Но так же очень важным является то, какое значение статического веса имеет та страничка, с которой ведет ссылка на документ. Дело в том, что по ссылке передается часть значения PageRank странички донора.

Но и это еще не все. Дело в том, что если со странички донора проставлено несколько ссылок (одна из которых на наш документ), то передаваемый статический вес будет поделен между всеми этим линками поровну.

То количество PR, которое страничка может передать по ссылке, намного меньше ее собственного значения (раньше это было 85 процентов, а сейчас по наблюдениям уже меньше 10%). Это количество статвеса и будет делиться между документами, на которые она ссылается.

Идеальным будет случай, если со странички имеющей Page Rank равный 10 (максимально значение) на ваш документ будет проставлена ссылка, открытая для индексации (без атрибута rel="nofollow"). И совсем здорово будет, если она будет одна единственная.

В этом случае вашем документу будет передан гигантский вес, достаточный, наверное, чтобы ПР вашей странички поднялся до 9. Если же с этого идеального донора будет проставлено еще несколько ссылок (включая вашу), то вес, передаваемый по каждой из них, будет уже поделен на общее количество и девятку вы уже не получите. Обидно, правда? А так хотелось.

Да, чуть не забыл рассказать о том, как и в чем измеряется значение PageRank, а так же о том, как запретить передачу голоса (веса) по ссылке, ведущей со страничек вашего проекта. Сначала о единицах измерения. Тут существует две шкалы и, соответственно, два значения.

Первый из вариантов представления выражает его вещественным числом и имеет линейный характер изменения. Т.е. увеличение этого значения будет пропорционально увеличению количества статического веса, передаваемого на данный документ по ссылкам с других ресурсов интернета. Это число обновляется практически в реальном времени и постоянно учитывается при ранжировании.

Второй вариант представлял PR является производным от первого. Это значение называлось тулбарным значением и имело диапазон изменения от 0 до 10 (всего получается одиннадцать возможных вариантов).

Сейчас Гугл не дает возможности посмотреть тулбарное значение ПейжРанка.

Тулбарная цифра получалась из вещественного числа по закону близкому к логарифмическому (сильно нелинейному):

| Вещественное число, обозначающее реальный статвес | Тулбарное число, получаемое в результате |

|---|---|

| от 0,00000001 до 5 | 1 |

| от 6 до 25 | 2 |

| от 26 до 125 | 3 |

| от 126 до 625 | 4 |

| от 626 до 3125 | 5 |

| от 3126 до 15625 | 6 |

| от 15626 до 78125 | 7 |

| от 78126 до 390625 | 8 |

| от 390626 до 1953125 | 9 |

| от 1953126 до бесконечности | 10 |

Тулбарная цифирька обновлялась не часто — раз в несколько месяцев. Его нулевое значение обычно имеют новые ресурсы или же проекты, попавшие под бан Google, а цифру равную 10 имеют только несколько колоссов во всем интернете.

Как вы можете видеть из приведенной выше таблицы — сначала для наращивания Page Rank не потребуется много ссылок с хорошим весом, но с каждым новой цифирькой его дальнейшее увеличение становится все более сложной, а зачастую и невыполнимой задачей.

В среднем, хорошо оптимизированные (и внутренне, и внешне) ресурсы имеют PR главной страницы равный 4 или 5, а некоторые добиваются даже шестерки, но дальнейший рост этого показателя доступен только очень серьезным и глобальным проектам.

Так что, предел наших с вами мечтаний и возможностей — это скорей всего 6, да и то вряд ли. Скажете, что я пессимист?! Да нет, скорее я реалист. Но если вы вдруг получите (или уже получили) Пейдж Ранк равный 7, то отпишитесь, пожалуйста, об этом в комментариях (и обязательно поставьте ссылку на https://ktonanovenkogo.ru, чтобы и у меня стало все хорошо).

Запрещаем передачу статического веса через внешние ссылки

В принципе, сделать это совсем не сложно. Google позаботился о том, чтобы была возможность не отдавать голос на другой ресурс. Для этого достаточно будет добавить в тег ссылки A атрибут rel="nofollow" (чуть выше я уже приводил линк на статью, где это подробно все разжевывается). Например так:

<a href="https://ktonanovenkogo.ru" >Все о создании сайтов, блогов, форумов, интернет-магазинов, их продвижении в поисковых системах и заработке на сайте</a>

После этого статвес с донора не будет передаваться на акцептор (тот документ, на который ведет линк). Для чего может понадобиться запрещать передачу веса? Тут все довольно просто. Нужно только вспомнить, что PR может передаваться не только по ссылкам, ведущим на другие проекты, но и по линкам, ведущим на внутренние страницы вашего же ресурса.

Теперь представьте такую ситуацию, что у вас в одном документе проставлено десять внутренних и десять внешних ссылок. Всего получается двадцать. Статический вес, передаваемый по каждой из них, будет равен одной двадцатой от максимально возможного, который способен отдать данный документ (донор). Следовательно, акцепторы получат одну двадцатую максимально возможного веса (пейджранка).

А теперь представьте, что во всех внешних ссылка вы прописали атрибут rel="nofollow", тем самым запретив передавать по ним вес. В результате весь вес, который способен отдать донор, будет распределен между десятью внутренними ссылками. По каждой из них будет передан вес в одну десятую от максимально возможного, что в два раза больше, чем в случае без использования атрибута rel="nofollow".

Таким образом, вы препятствуете утеканию PageRank с вашего проекта, аккумулируя его внутри и повышая свои собственные пузомерки. В результате, эти странички вашего ресурса при прочих равных условиях смогут занять более высокое место в поисковой выдаче Google за счет сбереженного статвеса.

P.S. Есть мнение, что сейчас Гугл несколько изменил действие атрибута rel="nofollow" и ваши внутренние документы в приведенном примере все равно получат по одной двадцатой веса, а все остальное утечет неизвестно куда. Мнение спорно, но...

Динамический вес, зависящий от текста ссылки (анкора)

До этого момента мы говорили только про статические веса. Однако, при расчете трансляции веса для любой ссылки, поисковые машины используют два типа весов. Первый — статический, о котором мы уже поговорили и который рассчитывается без учета текста ссылки (ее анкора). Второй — динамический (анкорный), который рассчитывается на основании нескольких параметров:

- Тематика донора (откуда проставлена ссылка)

- Содержимое (тематика) анкора

- Тематичность акцептора (страницы вашего сайта)

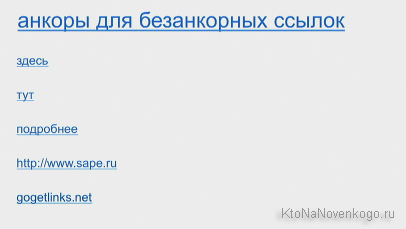

Чем более релевантны эти три составляющие, тем более высокий анкорный вес будет транслировать ссылка. Если у ссылки нет анкора (безанкорная), то динамический вес, передаваемый по ней, не рассчитывается вовсе. Статический вес передается всегда, если только сайт донор не находится под фильтром поисковых систем за продажу бэклинков.

Отсюда можно сделать очень важный вывод — любая ссылка, проставленная на ваш сайт, может быть ценна для вас двумя своими весами. Во-первых, мы нагоняем статический вес своей вебстраницы, что есть хорошо. Но если еще грамотно использовать анкор, то значимость этой же ссылки может быть увеличена в несколько раз.

Что нужно сделать, чтобы получить высокий анкорный вес? Попробуем расписать по пунктам:

- Донор должен иметь максимально возможный авторитет в поисковых системах. Точнее та страница, откуда проставляется бэклинк. Раньше можно было об этом судить, глядя на значение ПейджРанка этой страницы — чем меньше оно будет отличаться от 10, тем лучше, но сейчас это увы в прошлом. Придется пользоваться платными инструментами различных сервисов проверки сайта.

- Страница-донор должна быть максимально близка по тематике к странице-акцептору (продвигаемой вами).

- Анкор ссылки тоже должен быть максимально тематическим странице-акцептору (ее контенту, т.е. тексту).

Про использование в анкорах прямых и разбавленных вхождений ключевых слов вы можете почитать по приведенной чуть выше ссылке.

Алгоритмы прямых и обратных индексов

Очевидно, что метод простого перебора всех страниц, хранящихся в базе данных, не будет являться оптимальным. Этот метод называется алгоритмом прямого поиска и при том, что этот метод позволяет наверняка найти нужную информацию не пропустив ничего важного, он совершенно не подходит для работы с большими объемами данных, ибо поиск будет занимать слишком много времени.

Поэтому для эффективной работы с большими объемами данных был разработан алгоритм обратных (инвертированных) индексов. И, что примечательно, именно он используется всеми крупными поисковыми системами в мире. Поэтому на нем мы остановимся подробнее и рассмотрим принципы его работы.

При использовании алгоритма обратных индексов происходит преобразование документов в текстовые файлы, содержащие список всех имеющихся в них слов.

Слова в таких списках (индекс-файлах) располагаются в алфавитном порядке и рядом с каждым из них указаны в виде координат те места в вебстранице, где это слово встречается. Кроме позиции в документе для каждого слова приводятся еще и другие параметры, определяющие его значение.

Если вы вспомните, то во многих книгах (в основном технических или научных) на последних страницах приводится список слов, используемых в данной книге, с указанием номеров страниц, где они встречаются. Конечно же, этот список не включает вообще всех слов, используемых в книге, но тем не менее может служить примером построения индекс-файла с помощью инвертированных индексов.

Обращаю ваше внимание, что поисковики ищут информацию не в интернете, а в обратных индексах обработанных ими вебстраниц сети. Хотя и прямые индексы (оригинальный текст) они тоже сохраняют, т.к. он в последствии понадобится для составления сниппетов, но об этом мы уже говорили в начале этой публикации.

Алгоритм обратных индексов используется всеми системами, т.к. он позволяет ускорить процесс, но при этом будут неизбежны потери информации за счет искажений внесенных преобразованием документа в индекс-файл. Для удобства хранения файлы обратных индексов обычно хитрым способом сжимаются.

Математическая модель используемая для ранжирования

Для того, чтобы осуществлять поиск по обратным индексам, используется математическая модель, позволяющая упростить процесс обнаружения нужных вебстраниц (по введенному пользователем запросу) и процесс определения релевантности всех найденных документов этому запросу. Чем больше он соответствует данному запросу (чем он релевантнее), тем выше он должен стоять в поисковой выдаче.

Значит основная задача, выполняемая математической моделью — это поиск страниц в своей базе обратных индексов соответствующих данному запросу и их последующая сортировка в порядке убывания релевантности данному запросу.

Использование простой логической модели, когда документ будет являться найденным, если в нем встречается искомая фраза, нам не подойдет, в силу огромного количества таких вебстраниц, выдаваемых на рассмотрение пользователю.

Поисковая система должна не только предоставить список всех веб-страниц, на которых встречаются слова из запроса. Она должна предоставить этот список в такой форме, когда в самом начале будут находиться наиболее соответствующие запросу пользователя документы (осуществить сортировку по релевантности). Эта задача не тривиальна и по умолчанию не может быть выполнена идеально.

Кстати, неидеальностью любой математической модели и пользуются оптимизаторы, влияя теми или иными способами на ранжирование документов в выдаче (в пользу продвигаемого ими сайта, естественно). Матмодель, используемая всеми поисковиками, относится к классу векторных. В ней используется такое понятие, как вес документа по отношению к заданному пользователем запросу.

В базовой векторной модели вес документа по заданному запросу высчитывается исходя из двух основных параметров: частоты, с которой в нем встречается данное слово (TF — term frequency) и тем, насколько редко это слово встречается во всех других страницах коллекции (IDF — inverse document frequency).

Под коллекцией имеется в виду вся совокупность страниц, известных поисковой системе. Умножив эти два параметра друг на друга, мы получим вес документа по заданному запросу.

Естественно, что различные поисковики, кроме параметров TF и IDF, используют множество различных коэффициентов для расчета веса, но суть остается прежней: вес страницы будет тем больше, чем чаще слово из поискового запроса встречается в ней (до определенных пределов, после которых документ может быть признан спамом) и чем реже встречается это слово во всех остальных документах проиндексированных этой системой.

Оценка качества работы формулы асессорами

Таким образом получается, что формирование выдач по тем или иным запросам осуществляется полностью по формуле без участия человека. Но никакая формула не будет работать идеально, особенно на первых порах, поэтому нужно осуществлять контроль за работой математической модели.

Для этих целей используются специально обученные люди — асессоры, которые просматривают выдачу (конкретно той поисковой системы, которая их наняла) по различным запросам и оценивают качество работы текущей формулы.

Все внесенные ими замечания учитываются людьми, отвечающими за настройку матмодели. В ее формулу вносятся изменения или дополнения, в результате чего качество работы поисковика повышается. Получается, что асессоры выполняют роль такой своеобразной обратной связи между разработчиками алгоритма и его пользователями, которая необходима для улучшения качества.

Основными критериями в оценке качества работы формулы являются:

- Точность выдачи поисковой системы — процент релевантных документов (соответствующих запросу). Чем меньше не относящихся к теме запроса вебстраниц (например, дорвеев) будет присутствовать, тем лучше

- Полнота поисковой выдачи — процентное отношение соответствующих заданному запросу (релевантных) вебстраниц к общему числу релевантных документов, имеющихся во всей коллекции. Т.е. получается так, что во всей базе документов, которые известны поиску вебстраниц соответствующих заданному запросу будет больше, чем показано в поисковой выдаче. В этом случае можно говорить о неполноте выдаче. Возможно, что часть релевантных страниц попала под фильтр и была, например, принята за дорвеи или же еще какой-нибудь шлак.

- Актуальность выдачи — степень соответствия реальной вебстраницы на сайте в интернете тому, что о нем написано в результатах поиска. Например, документ может уже не существовать или быть сильно измененным, но при этом в выдаче по заданному запросу он будет присутствовать, несмотря на его физическое отсутствие по указанному адресу или же на его текущее не соответствие данному запросу. Актуальность выдачи зависит от частоты сканирования поисковыми роботами документов из своей коллекции.

SEO словарь — как начать понимать термины, которые используют СЕО-шники

Люди, работающие в какой-то отрасли, используют в своем общении термины, которые помогают быстро объяснить суть дела не отвлекаясь на детали.

Из-за этого разговор профессионалов часто кажется непонятным неподготовленному слушателю, которому эти детали, ох как важны для понимания. То же самое происходит и в SEO отрасли, где общение происходит с использованием устоявшейся терминологии.

Все мы, конечно же, люди догадливые и по контексту можем домыслить смысл непонятных слов, но все же лучше будет разом с ними всеми ознакомиться, чтобы уже потом не ломать над этим голову. Собственно, в этой статье я и собрал те фразы, которыми изобилует речь Сеошников или тех, кто хочет ими казаться. Если что-то упустил или допустил ошибку в интерпретации, то попинайте в комментариях.

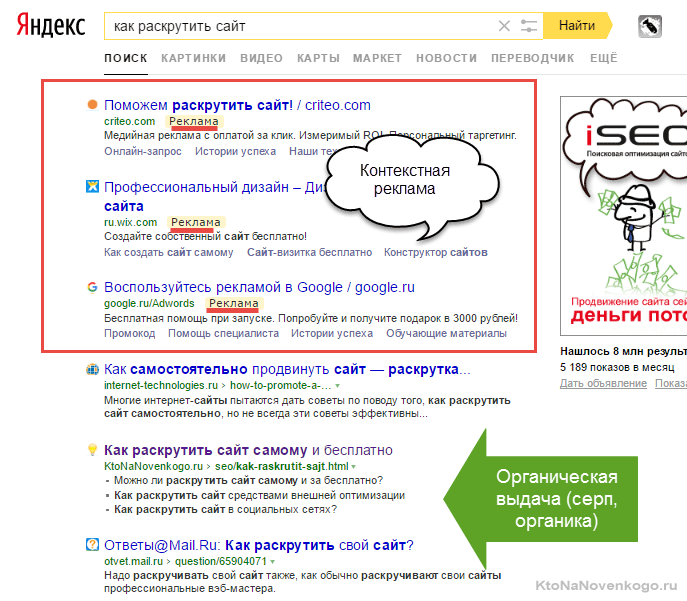

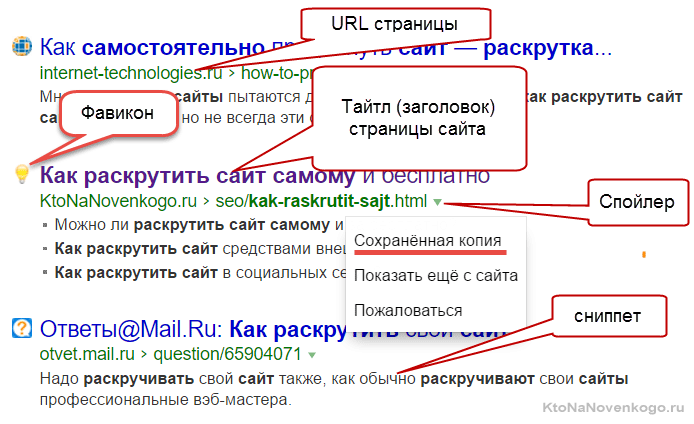

Серп, Топ, сниппет и тайтл

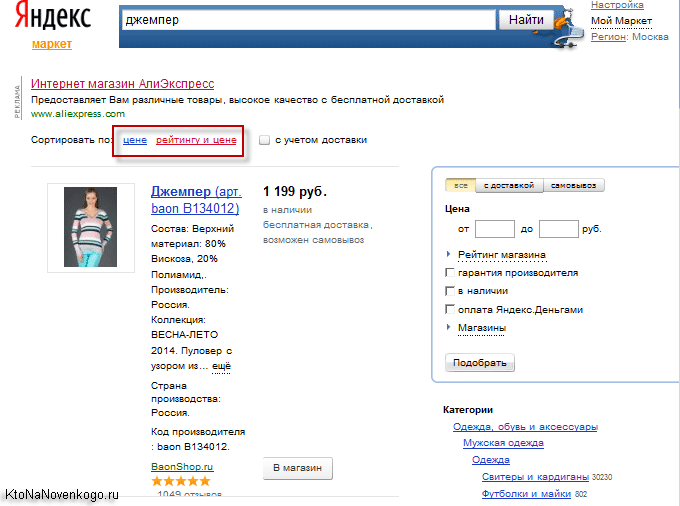

- SERP (выдача) — страница поисковой системы, которую видит пользователь в ответ на введенный им запрос. Состоит он из двух частей — органическая выдача (по десять результатов на одной странице) и контекстная реклама (несколько блоков сверху, снизу или сбоку от основных результатов поиска). Как раз за попадание в Топ 10 органики и ведут борьбу SEO специалисты.

Органическая выдача состоит из вебстраниц, которые признаны поисковой системой релевантными запросу. Чаще всего один сайт в выдаче представлен только один раз, но бывают и исключения. Например, в серпе по брендовым запросам.

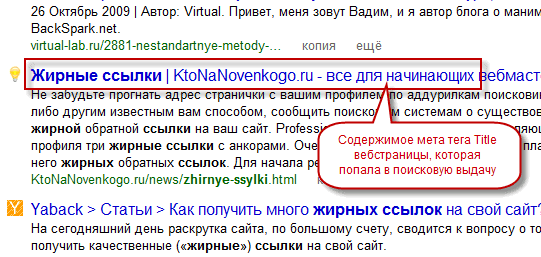

Само объявление для каждой такой вебстраницы в выдаче (серпе) оформлено по определенным правилам. В Яндексе и Гугле их внешний вид чуток отличается (например, в Яндексе имеются фавиконы, а в Google могут быть фото авторов статей).

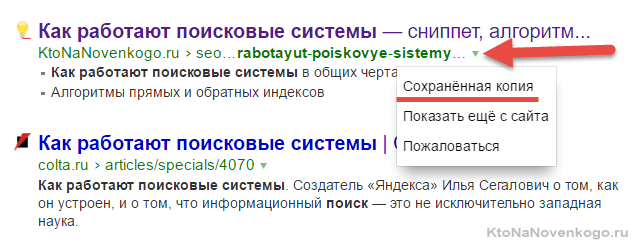

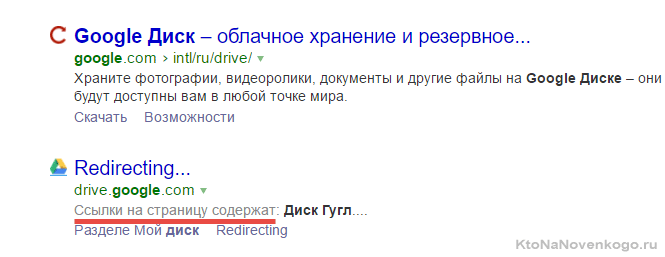

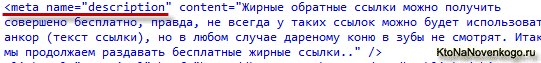

Заголовок этого объявления обычно берется из тайтла страницы (метатега Title, взятого из исходного Html кода) представленного сайта, но могут быть варианты и использования в качестве оного промежуточных заголовков имеющихся на этой странице. - Сниппет — располагается в выдаче чуть ниже тайтла и Урла любого объявления. Представляет из себя фрагмент текста взятого с вебстраницы попавшей в серп. Иногда поисковики формируют его на основе содержимого метатега description (описания страницы), но также этот текст может быть взят из самого тела статьи. Так же сниппет может изредка представлять из себя надпись «Ссылки на страницу содержат», когда искомый запрос не встречается на странице, а присутствует только в текстах ссылок, ведущих на нее. Пример смотрите чуть ниже при пояснении термина НПС.

По сути, это краткое содержание вебстраницы, которое берется из ее текста или содержимого мегатега дескрипшен. По нему пользователь поисковой системы может составить мнение о странице без перехода на нее. Сеошники пытаются влиять на сниппеты, ибо это позволит привлечь больше посетителей. Как это сделать? Думаю, что мы еще об этом поговорим поподробнее.

- Топ — как правило, под этим подразумевается первая страница выдачи поисковой системы. По умолчанию, на ней отображается десять наиболее релевантных запросу вебстраниц различных сайтов. Это можно назвать Топ 10. Однако, у Сеошников бывают разные задачи, поэтому встречаются такие вещи, как Топ 1, 3, 5, которые показывают тот потолок, которого они хотят достигнуть в результате продвижения (попасть на первое места серпа, в тройку или в пятерку первых). Процент переходов с разных мест первой страницы выдачи настолько разнится, что драка за Топ идет не на жизнь, а на смерть.

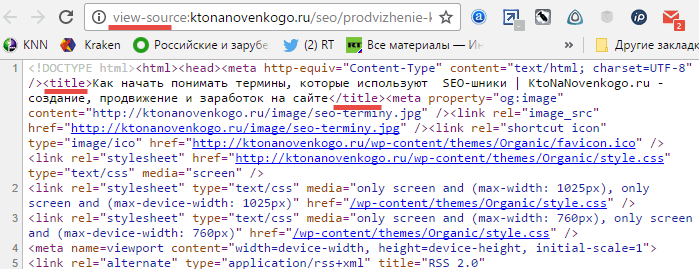

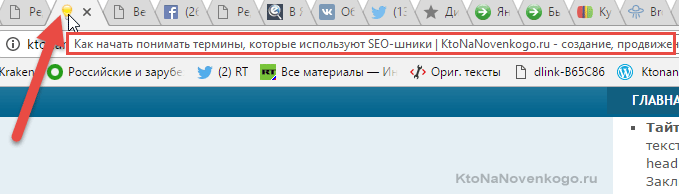

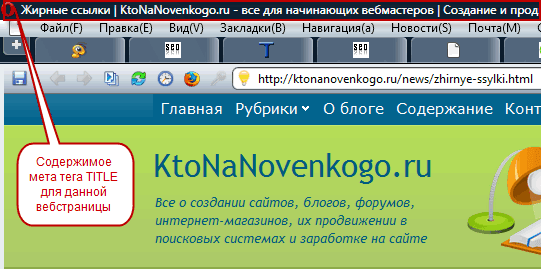

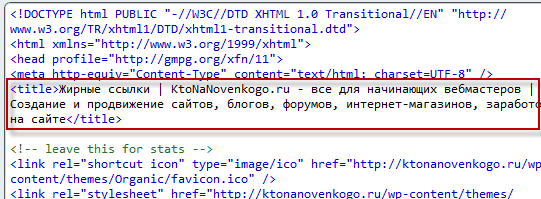

- Тайтл (title) — в Сео терминологии под этим понимают заголовок вебстраницы. Физически это текст, который в Html коде окружается тегами title и располагается в головной части (между тегами head).

В браузере его можно посмотреть, подведя курсор мыши к одной из открытых вкладок.

Заключенные в него ключевые слова будут иметь больший вес для поисковиков, и его содержимое часто используется в качестве заголовка объявления в поисковой выдаче (см. скриншот выше).

Индекс, ранжирование, фильтры и дэнс

- Индекс — база данных поисковых систем, где они хранят в разобранном на слова виде все содержимое интернета, которое им удалось проиндексировать. Поиск ведется не по «живым» текстам на сайтах, а именно по словам в этом индексе, что в сотни раз ускоряет процесс. Для того, чтобы начать продвижение страницы сайта, надо сначала дождаться того, пока она попадет в индекс и начнет участвовать в ранжировании по релевантным ее ключевым словам запросам (эти термины описаны чуть ниже).

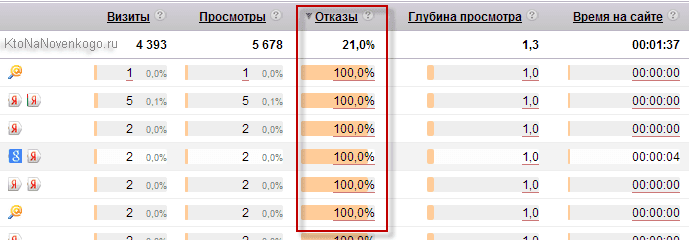

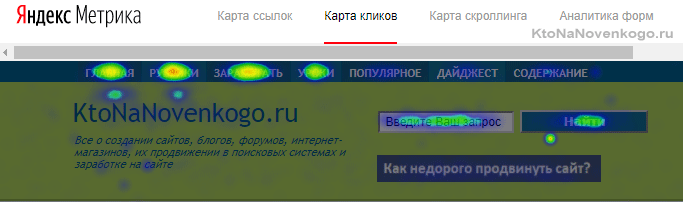

- Ранжирование — сортировка сайтов в поисковой выдаче. У поисковых систем существует множество факторов (сотни) для ранжирования. Обычно, среди них выделяют такие группы, как внутренние (оптимизация сайта, внутренняя перелинковка), внешние (статический и динамический вес проставленных из вне ссылок), поведенческие факторы (поведение пользователей в выдаче и на самом сайте), а также социальные (расшаривания страниц в соцсетях, лайки, комментарии т.п.).

- Ключевые слова — они характеризуют содержимое вебстраницы, чтобы поисковой системе было проще понять о чем идет речь и каким запросам релевантна данная страница. В SEO это архиважный термин, ибо от правильного подбора ключевых слов и их дальнейшего использования на страницах сайта, а также в анкорах ссылок зависит успех продвижения.

- Поисковые запросы — то, что вводят пользователи в поисковую строку Яндекса, Гугла и других систем. Где можно посмотреть статистику поисковых запросов, чтобы на их основании выбрать себе ключевые слова? Правильно, в самих поисковиках. У них есть инструменты, помогающие пользователям контекстной рекламы получить доступ к этой информации. Читайте про это в статье по приведенной ссылке.

- Релевантность — соответствие поискового запроса содержимому вебстраницы. Все релевантные запросу документы попадают на стадию ранжирования, чтобы определить их позицию в итоговой выдаче. Хотите больше информации? Читайте статью про релевантность и ранжирование.

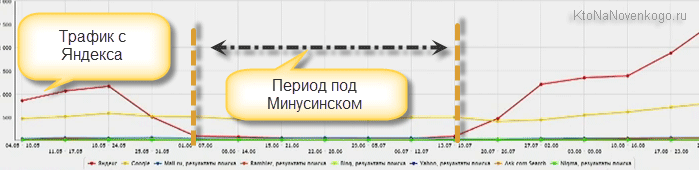

- Пессимизация — понижение страниц сайта в выдаче по каким-то отдельным или даже по всем поисковым запросам (ключевым словам). По сути, это искусственное занижение релевантности. Обычно является следствием каких-либо выявленных нарушений в оптимизации или продвижении. В следствии этого снижается трафик на сайт и сеошник начинает искать и исправлять причины наложения фильтра и пессимизм сайта.

- Фильтры — способы автоматической борьбы поисковых систем с сайтами, которые путем накруток пытаются занять место выше, чем они того заслуживают. С помощью фильтров поисковики пытаются нивелировать действия накруток. Чтобы выйти из под фильтра, нужно будет устранить причину его наложения (например, переоптимизацию текста, как это было в моем случае).

- Бан — полное исключение страниц сайта из индексной базы поисковой системы. Налагается за очень грубое нарушение лицензии использования поисковых систем (например, невидимый текст, клоакинг и другое). Более подробно про фильтры, пессимизацию и бан в Яндексе вы можете почитать по приведенной ссылке.

- Апдейт (ап) — в общем смысле слова, это обновление. Применительно к Сео и поисковым системам это может быть апдейт алгоритма ранжирования и вызванное этим обновление базы данных (рассчитанных на основе этих алгоритмов), которое происходит не сразу, а от апа к апу. Это приводит к изменению серпа (выдачи), т.е. меняются позиции сайтов по тем или иным запросам. Это и есть апдейт выдачи, который чаще всего и понимают под общим термином апдейта применительно к SEO. Можете почитать про апдейты, которые бывают в Яндексе.

- Дэнс — процесс изменения выдачи, который мы наблюдаем мониторя позиции своего сайта (они при этом могут прыгать на десятки и даже на сотни мест вверх или вниз). Дело в том, что поисковую выдачу не возможно обновить одномоментно после обновления или подкрутки алгоритма (программного обеспечения поисковиков). Это связано с ограниченностью технических возможностей. Кроме этого, сами алгоритмы имеют обратную связь и подстраиваться могут постоянно, поэтому дэнс может длится как днями, так и месяцами, пока все более-менее не устаканится.

- Кэш (сохраненная копия) — html версия вебстарницы из выдачи, которая хранитяс в базе поисковых систем. Ее можно посмотреть, например, в Яндексе, воспользовавшись ссылкой «Сохранная ккопия», которая появится при клике по спойлеру в виде маленькой стрелочку в конце URL адреса страницы:

Иногда, эта ссылка помогает увидеть страницу на сайте, который сейчас временно недоступен (есть еще и архив интернета, но это уже возиться надо). Кэш нужен поисковикам для того, чтобы иметь возможность формировать сниппеты для своей выдачи, ибо вытащить его из обратного индекса крайне затруднительно, а лазить постоянно на страницу-источник весьма накладно.

Аффилиат, асессор, сквозняк и стоп-слова

- Аффилиат — в выдаче по какому-либо запросу чаще всего представлены разные сайты. Однако, у многих возникает желание оккупировать весь Топ10. Но как это сделать? Правильно, нужно создать десять разных сайтов, которые будут принадлежать вам и все их продвигать в Топ. Это и будет аффилиат. Яндекс и Гугл с этим борются, определяя интернет-магазины и другие коммерческие сайты принадлежащие одному владельцу, и оставляют в индексе только одни из них. Этим, кстати, пользуются и мошенники, выкидывая из индекса таким образом сайты конкурентов.

- Трафик — довольно общий термин (что такое трафик), но в SEO обычно под этим понимают трафик на страницу или на сайт (количество посетителей пришедших за определенный промежуток времени, например, за сутки). Трафик бывает поисковый (из выдач Яндекса, Гугла и других поисковиков), из закладок (имеются в виду закладки в браузере), покупной и т.п.

- Контент — я уже довольно подробно писал про то, что такое контент и насколько он важен для продвижения сайта. Понятие это несколько более широкое, чем просто текст, но при разговоре о Сео имеется в виду именно его текстовая составляющая. Очень часто идет разговор об уникальном контенте, о защите контента от копирования и т.п. вещах, ибо поисковые системы удаляют дубли со своих серверов и они не участвуют в поиске. Существуют специальные биржи контента, где при желании можно заказать или купить уже готовую статью.

- Копипаст — банально скопированный контент. Я не скажу, что, используя копипаст на своем сайте, вы гарантированно попадете под фильтр, но однозначно ни к чему хорошему это не приведет. Тем не менее, это одна из основных составляющих современного интернета.

- Копирайтинг — уникальные тексты написанные «с нуля». Предпочтительный вид контента для СДЛ (термин описан ниже), ибо при должном подходе имеет все шансы занимать высокие позиции в выдаче.

- Рерайт — что-то среднее между двумя описанными выше терминами. Берется какой-то текст и переписывается другими словами с сохранением смысла. В общем-то, это лучше, чем копипаст, но поисковиками «палится на раз», поэтому используйте рерайт только высокого класса, а еще лучше переходите на копирайтинг.

- Асессор — штатный сотрудник Яндекса или Гугла, в задачу которого входит оценка поисковой выдачи по определенным критериям (и для определенных запросов), которая была получена в результате работы алгоритма. Эти оценки служат обратной связью, позволяющей вносить изменения в этот самый алгоритм, чтобы пользователи поисковика оставались им довольны, а выдача была бы релевантной (см. термин чуть ниже) запросу.

- Донор (отдает) — в Сео под этим термином понимают вебстраницу (или сайт), с которой проставлена ссылка на продвигаемую вами страницу. Подразумевается, что донор передает часть своего веса (крови) по этой ссылке (при этом свой собственный вес не теряя, как не парадоксально это звучит). Если я из этой статьи поставлю ссылку на вашу статью, то стану донором, а вы акцептором.

- Акцептор (принимает) — вебстраница, на которую ведет ссылка с донора. По сути вся сеть пронизана донор-акцепторными связями, ибо это изначально было заложено при определении что такое будет интернет Тимом Бернерсом-Ли (технология гипертекста с гиперссылками в качестве связующих элементов).

- Бэклинки (обратные ссылки) — ссылки на ваш сайт с других ресурсов (доноров).

- Анкор — текст ссылки (то, что находится между открывающим и закрывающим Html тегами гиперссылки). Тут не добавить, не убавить. Ссылки могут быть анкорными и безанкорными. Очень важный Сео термин, который учитывается при ранжировании поисковыми системами, и вы можете встретить в сети множество советов о процентном соотношении использовании ключевых слов в анкорах обратных ссылок (чуть ниже этот термин смотрите). Есть такие понятия, как прямые вхождения ключа в анкоре, разбавленные или безанкорные. Читайте подробнее про анкоры тут.

- Статический вес ссылки — поисковые системы в ранжировании учитывают не только динамический вес ссылок (анкоры), но и статический, который определяется изначальным весом страницы донора и числом вебстраниц, на которые она ссылается. Подробности читайте в упомянутой чуть выше статье.

- Жирная ссылка — так называют обратную ссылку (бэклинк) полученную с очень трастового ресурса (с высоким Тиц, например). Еще лучше, если эта ссылка будет проставлена с главной страницы, например, как в случае со студией Лебедева, на которую ведет бэклинк с главной самого Яндекса. К получению жирных ссылок все стремятся, ибо это поднимает траст всего ресурса в целом и может повлечь за собой рост трафика.

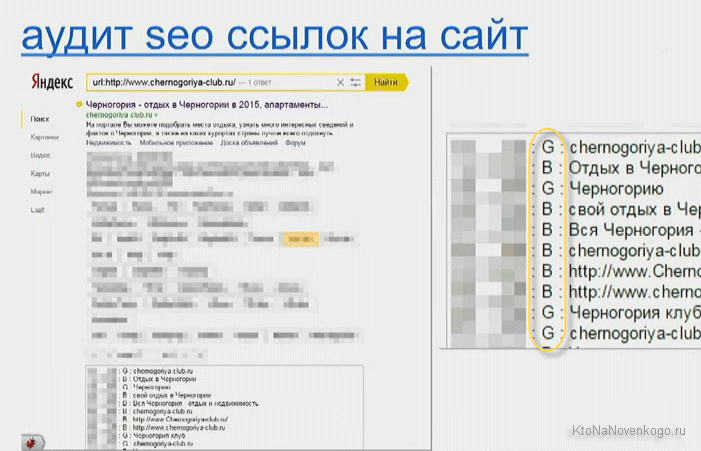

- НПС — найдено по ссылке (сейчас в выдаче Яндекса это обозначается чуть по другому: «Ссылки на страницу содержат»). Дело в том, что при ранжировании вебстраниц учитываются также и анкоры (тексты) ссылок, которые ведут на эту страницу. Поэтому при ответе на ваш запрос поисковая система может предлагать документы, в которых вводимый вами запрос не встречается, но зато имеются ведущие на него ссылки, содержащие эти слова.

Соответственно, не имея возможности сформировать сниппет со словами запроса, Яндекс пишет «Ссылки на страницу содержат: текст запроса». Лет семь-восемь назад можно было загнать в Топ любую страницу с любым содержанием, просто проставив на нее кучу анкорных ссылок с нужными ключевыми словами. - Сквозняк — сквозная ссылка, которая имеет место быть на всех страницах сайта. Например, на моем блоге это ссылка с названия блога KtoNaNovenkogo.ru или со счетчика посещений, размещенного на всех страницах. Сеошники при покупке сквозных ссылок стараются каким-то хитрым образом получить в них разные анкоры, чтобы в глазах поисковых систем она не склеилась, т.е. приравнялась к одной.

- Перелинковка — чаще всего под этим подразумевается внутренняя перелинковка, которая может служить как удобству пользования сайтом, так и для перераспределения статического веса между страницами сайта нужным образом. Реализовываться может как вручную (из контекста статей), так и автоматически (хлебные крошки, облако тегов, меню, похожие материалы, карта сайта и т.п.).

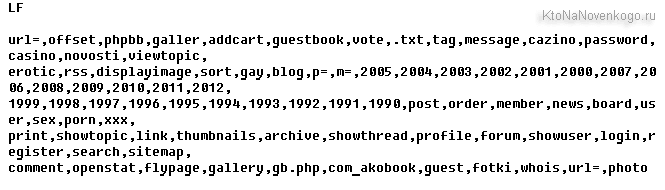

- Стоп-слова — в русском языке существуют служебные части речи (союзы, предлоги), которые при анализе текста практически на влияют не его смысл (семантику). При разборе текста, в поисковых системах и создании обратного индекса, зачастую они просто отбрасываются для упрощения и экономии ресурса. Иногда их еще называют минус-словами.

- Пассажи — при индексации сайтов поисковики из загруженного Html кода вебстраницы извлекают текст видимый посетителям, удаляют из него все стоп-слова (союзы, предлоги) и знаки препинания. Полученный в результате набор слов бьют на так называемые пассажи. По сути это предложения, но с некоторыми допущениями. Пассажи, как и предложения, объединяются смысловой законченностью, но оперировать именно предложениями при машинном анализе русского текста практически не возможно (в силу его «великости и могучести»). Т.е. анализ ведется не по физическим (изначально имеющимся в тексте) предложениям, а по вновь созданным (машинным), которые и назвали пассажами.

СДЛ, ГС, конверсия и алиас

- СДЛ (сайт для людей) — такие ресурсы создаются и развиваются в непосредственном контакте со своими посетителями. В общем, нормальные сайты, какими они и должны быть. Существуют СДЛ, как правило, балансируя между потребностями посетителей и желанием владельцев побольше заработать (на рекламе, продаже ссылок и т.п. вещах, описанных в статье про заработок на СДЛ).

- ГС (го-но сайты) — создаются исключительно для обмана поисковых машин и заработка на привлеченном поисковом трафике (либо на продаже ссылок со страниц, попавших в индекс поисковиков). Многие ГС можно с первого взгляда отличить от СДЛ, но поисковики не могут видеть, а потому таких ресурсов до сих пор полным-полно в выдаче. Сейчас Яндекс и Google активно с ними борются, но ГС живее всех живых. У Яндекса имеются фильтры АГС (анти ГС) с номерами 17, 30 и 40, которые призваны выкашивать этих паразитов.

- Дорвей (дор) — автоматически создаваемый ГС. Технологии их изготовления мне не известны (используются доргены, по-моему). По некоторым запросам и в Яндексе, и в Гугле можно наблюдать засилье доров, что не есть гуд. Живут они в индексе поисковиков не долго, но в силу автоматизации их создания на смену умершего приходит парочка новых.

- MFA — сайт, созданный под заработок на Адсенсе (Made for AdSense), хотя и под Рекламную сеть Яндекса, наверное, тоже делают. По сути, это разновидность ГС. Оптимизируются MFA под поисковые системы, в то же время не имея на своих страницах (многочисленных) чего-то, что может заинтересовать пользователя. Попадая туда, посетитель зачастую кроме объявлений Адсенса для себя ничего интересного не видит, поэтому кликает по ним с завидной регулярностью (на радость владельца).

- Морда — главная страница сайта (хомяк). Это страница сайта, которая открывается при наборе в адресной строке браузера основного хоста (ktonanovenkogo.ru, например). В Сео ссылки с морды стоят существенно дороже, чем ссылки с внутренних страниц.

- Конверсия — характеризует соотношение общего количества посетителей (трафика) пришедших на сайт к числу тех из них, кто совершил целевое действие (купил товар, заполнил форму, подал заявку на услугу, сделал звонок и т.п.). Для расчета конверсии число правильных посетителей делится на их общее число число и умножается на сто процентов.

- Сопли — Supplemental Results или, другими словами, дополнительный индекс поисковой системы Google. Сей поисковик настолько велик, что может позволить себе индексировать все подряд, однако не все попадает в основной индекс, по которому, собственно, и ведется поиск. Можете определить процент страниц своего сайта, находящихся в соплях, с помощью сервиса, описанного по приведенной выше ссылке или все в том же РДС баре.

- Быстробот — поисковый робот, который призван наполнять выдачу наисвежайшими материалами. Он посещает сайты, где часто появляется новая информации (например, блоги с RSS лентой или новостные ресурсы). Найденные страницы он ранжирует, опираясь лишь на некоторые внутренние факторы, и они мгновенно появляются в выдаче с указанием даты их создания. У меня не раз бывали всплески посещаемости, когда новая статья попадала в Топ Яндекса стараниями быстробота. Но на следующий день позиции резко ухудшались после прихода основного робота индексатора.

- Пузомерки — ИКС Яндекса, рейтинг домена в Ахрефс и другие показатели, которые могут так или иначе охарактеризовать успешность развития сайта.

- Чайник — это профан или начинающий пользователь. Подавляющая часть пользователей интернета (около 90%) являются чайниками и именно они определяют многие аспекты функционирования сети. По сути, весь интернет настроен на них, а значит это нужно учитывать при создании своего сайта.

- Яндексоид — сотрудник Яндекса.

- Платон Щукин — собирательный образ работника техподдержки Яндекса.

- Адурилка — форма для добавления новых страниц в поисковые системы. По ссылке вы найдет статью со ссылками на наиболее известные аддурилки.

- Алиас — псевдоним или же дополнительное доменное имя, которое приводит на один и то же физический сайт. Про самый распространенный алиас я писал в статье про домены с WWW без оного.

- Зеркало — копия основного сайта на другом домене. Такая ситуация может возникнуть, например, при переносе сайта на новое доменное имя. В индексе поисковика новый сайт (основной) появится только после того, когда робот зеркальщик выполнить свою работу (иногда приходится ждать месяцами его прихода). Так же зеркала могут использоваться для распределения нагрузки на сервера или для перераспределения трафика между регионами.

- Серч (searchengines.guru) — один из самых популярных в рунете форумов посвященных SEO продвижению. Там обсуждают нововведения поисковиков, решаются разные проблемы, ну, и просто иногда очень интересно бывает почитать мнения по тому или иному вопросу.

SEO, обратные ссылки, ПР, Тиц, ИКС и дорвеи

- SEO (Search Engine Optimization, Поисковая оптимизация) — ряд мероприятий, осуществляемых seo специалистами или seo любителями с вебсайтом, направленных на поднятие позиций по определенным запросам пользователей в выдаче (списке результатов поиска) Яндекса и Гугла. SEO оптимизация включает в себя работы по изменению текстового наполнения, кода, структуры, ссылочных связей и т.п.

- Аддурилка — форма для добавления урла — add url.

- Белый каталог — каталог, который не требует размещения на вашем ресурсе обратной ссылки на этот каталог, как плату за то, что вы добавили в него свой сайт.

- БЭК-линк (back link) — обратная ссылка, ссылка на ваш ресурс, размещенная на другом вебсайте.

- Яша — поисковая машина номер 1 в рунете (читайте про настройка главной Яндекса).

- Рама — Рамблер.

- Болт — Webalta.ru (поисковая система).

- Морда — ссылка на главной странице сайта. Вес ссылки с морды в разы выше, чем на второстепенных страницах.

- Внутрянка или Внутряк — внутренняя страница вебсайта. С них тоже можно продавать ссылки в такой системе как sape и xap. Ссылки с внутренних страниц намного меньше ценятся при продвижении по сравнению с главными, но большое количество внутряков позволит увеличить тиц

- Линкопомойка — много ссылок ведущих на ресурсы разных тематик, размещенные на странице только для продвижения под Yandex и Google, а не для пользователя. За такие страницы Яндекс, как правило, применяет различные санкции вплоть до бана. Не рекомендуется на своем проекте разводить линкопомойки, для продвижения необходимо делать как минимум строго тематический каталог, удобный для пользования.

- SE (Search Engines) — поисковые системы. Их довольно много, но для рунета, на данный момент, самыми важными являются Yandex и Google. Именно они дают вебмастерам рунета основной приток посетителей. Причем, не стоит недооценивать роль Google, на многих ресурсах трафик с Яндекса и Google примерно одинаковый.

- SERP (Search Engine Result Page) — страница выдачи результатов поиска (читайте про то, как нужно правильно гуглить).

- ПР или PR (Google PageRank) — это алгоритм расчёта авторитетности страницы (не всего сайта) в Google. Используются значения от 0 до 10. Проверить можно с помощью различных сервисов или же с помощью Google Toolbar. Более подробную информацию о PageRank вы сможете получить в этой статье — Google PageRank (PR) — что это такое и от чего зависит PR, в чем измеряется и как посмотреть PageRank, как PR влияет на положение в выдаче Google, информеры PageRank

- ВИЦ — взвешенный Индекс Цитирования (ИЦ) Yandex, учитывающий число страниц ссылающихся на документ и значимость этих вебстраниц. Рассчитывается для каждой страницы в базе этого поисковика. Обновляется два раза в неделю. Является одним из факторов, влияющих на положение страницы в результатах поиска при продвижении. В настоящее время значения ВИЦ не транслируются Яндексом и мы никак не может его оценить.

- ТИЦ — тематический индекс цитирования — это алгоритм расчёта авторитетности ресурса с учетом тематических ссылок на него. Сегодня уже устарел (его заменил ИКС, о котором речь пойдет ниже). Используется в системе Yandex. Проверить ТиЦ можно по адресу: http://search.yaca.yandex.ru/yca/cy/ch/ktonanovenkogo.ru — где ktonanovenkogo.ru нужно будет заменить на свое доменное имя (что это такое?). Рассчитывается для сайта в целом и показывает авторитетность ресурса относительно других, близких по тематике ресурсов (а не всего Интернета в целом). ТИЦ используется для ранжирования в каталоге Яндекса и не влияет на прямую на результаты поиска в Яндексе. Узнать больше о ТИЦ вы сможете из этой статьи — Тематический индекс цитирования Яндекса

- ИКС Яндекса (индекс качества сайта) это показатель, то или иное значение которого присваивается любому интернет-ресурсу. Поисковая система ввела этот параметр на смену тематическому индексу цитирования, который определял авторитетность сайта на основе того, сколько ссылок на него ведёт, причём разные ссылки имели разный вес.

- Сниппет — небольшой отрывок текста из найденной поисковой машиной вебстраницы, использующийся в качестве описания ссылки в результатах поиска (читайте про то, как правильно искать в Яндексе). Как правило, они содержат контекст, в котором встретилось ключевое слово в тексте на странице. В качестве сниппетов также может выводиться текст из метатэга Description. Почитать подробнее о назначении других мета-тегов вы можете в статье про оптимизацию блога на Вордрессе

- Хомяк — ваша домашняя страничка.

- Платник — хостинг на платном сервере. Например, Инфобокс или ProGoldHost (Проголдхост)

- Дорвей — это специально созданная html-страничка под определенный запрос пользователя, не несущая полезной информации, а предназначенная исключительно для продвижения. Обычно дорвеи содержат специально написанный нечитаемый текст, состоящий из популярных запросов пользователей. Как правило, посетители не успевают увидеть сам дорвей: их автоматически переадресовывают («редиректят») на раскручиваемый сайт, в то время как поисковому роботу туда путь закрыт. Если будет доказана причастность ресурса к дорвею, он будет исключен из базы данных поисковой системы в силу запрещенного метода продвижения. Дорвей является запрещенным методом продвижения.

- HTML — язык гипертекстовой разметки, который указывает браузеру с помощью тегов и их атрибутов, как именно должна выглядеть загружаемая вебстраница. На этом блоге есть рубрика под названием HTML для начинающих, в которой вы сможете найти ответы на основные вопросы по HTML.

- Урл или URL (Universal Resource Locator) — символьный адрес ресурса в Интернете. Представляет цифровой IP-адрес ресурса 89.208.146.82 в виде строки, например: https://ktonanovenkogo.ru или https://ktonanovenkogo.ru/vokrug-da-okolo/hosting-i-vse-chto-s-nim-svyzano.html

Индексация, боты трафик и хиты

- Весовой коэффициент — увеличивать релевантность (степень соответствия запроса и найденного, то есть уместность результата) документа может не только количество содержащихся в нем ключевых слов, но и их расположение в документе. Больший «вес» имеют слова в заголовке страницы (заголовок — это то, что находится между парным тегом H или внутри метатега Title), слова выделенные тегами, слова находящиеся ближе к началу документа.

- Индекс — индекс поисковой системы представляет собой гигантский информационный массив, где хранятся преобразованные особым образом текстовые составляющие всех посещенных и проиндексированных роботом НТМL-страниц и текстовых файлов. Робот не только пополняет массив новыми поступлениями, но и регулярно обновляет уже имеющиеся в индексах документы.

- Индексация страницы поисковой системой — внесение документа в базу данных Яндекса или Гугла. Как правило, происходит через некоторое время после подачи заявки на регистрацию.

- Концептуальный поиск — поиск документов, имеющих прямое отношение к указанному слову, а не просто содержащих его.

- Морфологический поиск — позволяет искать информацию не только по строго заданному слову, но и по всем его морфологическим формам (разных падежах, родах, числах и т.п.).

- Позиционирование в поисковых системах — мероприятия, предназначенные для достижения более высокого места в результатах поиска.

- Релевантность (уместность) документа — мера того, насколько полно тот или иной документ отвечает критериям, указанным в запросе пользователя. Разумеется, далеко не всегда документ, признанный Яндексом или Google наиболее релевантным, будет таким по мнению самого пользователя.

- Робот поисковой системы (бот) — это программа, являющаяся составной частью поисковика и предназначенная для обхода Интернета с целью занесения найденных документов в базу. Порядок обхода вебстраниц, частота визитов регулируется алгоритмами поисковой машины. С помощью файла robots.txt можно запретить индексацию всего сайта или его части, содержащего инструкции для ботов.

- Сабмитинг — подача заявки на регистрацию в поисковую систему.

- Стоп-слова — это Служебные единицы языка не несущие самостоятельной смысловой нагрузки. К ним относятся предлоги, союзы, междометия и т.д. Как правило, удаляются поисковой машиной из образа индексируемой страницы с целью снижения нагрузки на сервер и уменьшения размеров индекса. Оптимизация подразумевает уменьшение количества стоп слов по сравнению с полезным текстом. При обработке запроса пользователя стоп-слова также удаляются из запроса. У каждой машины обычно имеется свой собственный набор стоп-слов. К стоп-словам могут относиться и просто слишком часто встречающиеся в Интернете служебные последовательности знаков, например, http, www,.com.

- Трафик — объем данных, переданных и принятых web-сервером. Зависит от количества пользователей. Трафик появляется за счет продвижения по ключевым запросам.

- Хит — обращения пользователя к вебстранице, исключая перезагрузки. Повторный хит засчитывается при повторном обращении пользователя к документу по истечении 60 секунд по умолчанию.

- Хост — уникальный IP-адрес посетителя. Один посетитель может иметь несколько IP-адресов в случае, когда он выходит в интернет через Dial-Up соединение (модем) с провайдером и, наоборот, много посетителей на одном хосте (IP-адресе) — один офис подключен через выделенную линию, а все его сотрудники выходят в интернет через прокси-сервер.

- Чувствительность к регистру — чувствительность поисковой системы к заглавным и строчным буквам в запросе.

Частотность запросов, апдейты, тошнота, бан и релевантность

- НЧ-запрос (низкочастотник) — низкочастотный запрос. Они вводятся по нескольку сотен раз в месяц. Продвинуться по НЧ можно, вообще не используя внешнюю оптимизацию. Для этого достаточно будет грамотно провести оптимизацию внутреннюю (перелинковать статьи).

- Ссылка сквозная (сквозняк) — вебссылка со всех страниц сайта (главная + все внутренние). С помощью сквозняка хорошо поднимать PR или ТИЦ сайта, но при продвижении по запросам (для попадания по ним в топ) сквозняк не имеет особого преимущества по сравнению с обычной вебссылкой с главной страницы.

- Яка — каталог Яндекса.

- ДМОЗ (DMOZ) — Open Directory Project — популярный ненашенский каталог (dmoz.org ). К сожалению, уже закрылся. Имеет большое влияние на pr при продвижении (есть мнение, что на рунет это не распространяется). Добавление в ДМОЗ (DMOZ) производится на бесплатной основе. Русскоязычный ресурс можно добавить по адресу — dmoz.org/World/Russian.

- Клоакинг (Cloaking) — метод оптимизации, при котором поисковому роботу предоставляется один контент, а посетителям ресурса — другой. При обнаружении карается баном (ресурс исключается из базы поисковика).

- Пессимизация сайта — занижение позиций ресурса при его ранжировании в результатах поиска. Обычно возникает в результате использования методов «чёрной оптимизации». Яндекс и Гугл делают в целях повышения релевантности своей выдачи.

- Релевантность поиска — соответствие ответа вопросу. Важны две составляющие – полнота (ничего не потеряно) и точность (не найдено ничего лишнего).

- Бан — запрещение ресурса к индексации одним или несколькими поисковиками. Например, если Яндекс вас забанил, то ваш сайт на стартовой странице яндекса не найдется ни по одному из запросов.

- Тошнота страницы — степень неествественности текста. Тошнота увеличивается при явном переборе ключевых слов, большом кол-ве тегов strong и др. Она не обязательно ведет к пессимизации и уж тем более к бану, но может подпортить мнение поисковиков о вашем ресурсе.

- Поисковый спам — это любые приёмы или тексты, рассчитанные только на роботов поисковиков и не предназначенные для “живого” посетителя. Например, размещение невидимых для пользователя гиперссылок (как вариант — в виде прозрачной картинки размером 1×1) и создание, так называемых, Link Farm (линк-ферм, или ссылкопомоек) — вебстраниц с огромным количеством гиперссылок на разные ресурсы.

- АП (апдейт) — это обновление индекса Яндекса (у Google все происходит практически в реальном времени), приводящее к изменению позиций в выдаче. Апдейты проходят двумя способами — мгновенная очистка кеша и постепенная замена. В первом случае, во время начала апдейта мы видим сильные изменения в выдаче сразу, т.к. кеш очищен и выдача формируется в реальном времени, а во втором — выдача обновляется постепенно.

- Поисковая выдача SERP (search engine result page) — набор ссылок на сайты и их описания, выдаваемый в результате поиска. Ввели запрос и в результате получили список ресурсов, соответствующих по мнению поисковика вашему запросу. Этот список и будет поисковой выдачей.

- Семантическое ядро — это полный список запросов, по которым проект будет продвигаться. Разрабатывать структуру сайта нужно только после составления семантического ядра. Это даст Вам представление о разделах Вашего не созданного вебсайта и о материалах, которые на нем нужно будет размещать.

Ссылочное ранжирование (Link Popularity) — это влияние текстовой составляющей гиперссылки, проставленной с чужого сайта, на релевантность вебстраницы вашего ресурса по поисковым запросам, содержащимся в текстовой составляющей ссылки (ее анкоре). Это поиск по лексике анкоров, который является, пожалуй, самым интересным из критериев, оказывающих влияние на ранжирование документов в результатах поиска.

Ссылочное ранжирование — это иерархия по авторитету в выдаче Яндекса или Google. Если на ресурс ссылаются много других ресурсов, значит он авторитетный. Управлять всеми ссылающимися вебсайтами вебмастер не может, поэтому ссылочный критерий более объективный, чем текстовый. Дополняя друг друга, оба критерия позволяют поисковикам обеспечивать лучшие результаты поиска.

- Ссылочная популярность — это показатель того, сколько гиперссылок с внешних ресурсов ведет на ваш сайт, документ или домен, на котором он находится. Ссылочная популярность будет меняться в зависимости от поисковой системы, поскольку каждый поисковик имеет свою собственную базу данных и количество ссылок, хранящихся в базах различных систем различно. Гугловский PR и яндексовский ВИЦ являются показателями ссылочной популярности.

- Free-for-all (FFA) страницы — это место, где каждый может добавить свою гиперссылку. Т.к процесс автоматизирован, то нет никакой возможности его контролировать. Тысячи и тысячи нетематических ссылок находятся на страницах FFA. Единственная цель — это увеличение link popularity.

Анкоры, движки, виды оптимизации парсеры и песочница

- Анкор (anchor) — текст ссылки.

- «Черная» оптимизация — продвижение нечестными методами, поисковый спам. Для достижения результата используется размещение невидимого текста, использование дорвеев с редиректом, клоакинг, ссылочный спам (размещение невидимых для пользователя гиперссылок.)

- «Серая» оптимизация — оптимизация «вслепую», без учета особенностей проекта. Осуществляется, например, созданием дорвеев без редиректа, хаотичный обмен ссылками. Эффект от такой оптимизации минимальный.

- «Белая» оптимизация — работа с контентом и структурой сайта с целью сделать его наиболее удобным для посетителей и доступным для индексации поисковиками. Проводится путем оптимизации навигации на сайте, чисткой кода, добавлением контента, размещением ссылок на тематических ресурсах. Вы так же можете ознакомиться со статьей — Внутренняя оптимизация сайта

- Двиг, движок — программный код, на основе которого построен сайт. Чаще всего имеются в виду CMS (Content Management System) – Системы управления контентом. Оптимизация выдвигает к «движкам» ряд требований, которыми обычно пренебрегают многие разработчики CMS.

- Жирная ссылка — гиперссылка с вебстраницы с большим авторитетом (ТИЦ, PR). Важность этой ссылающейся страницы, в свою очередь, тем выше, чем больше количество и чем авторитетнее ссылки ведущую на эту вебстраницу.

- Затачивать — применительно к SEO, это оптимизация под поисковик, либо текста под ключевое слово.

- Киберсквоттеры — это те, кто регистрирует домены для продажи. Маржа киберсквоттера может превышать несколько сотен процентов.

- Мордовские ссылки — с главных вебстраниц (морд) сайтов.

- Непот фильтр — отказ поисковика учитывать гиперссылки с сайтов-спамеров.

- Непот лист — список ресурсов, которые попали под ограничения накладываемые непот фильтром.

- Парсер — программа, которая обеспечивает автоматическую обработку (разборку) вебстраниц сайтов с целью получения нужных данных. Парсеров в природе существует огромное множество, в зависимости от задачи, например, парсеры для сбора ключевых слов из сервиса wordstat.yandex.ru.

- Парсить — процесс проверки (разборки) данных, основной целью которого является обнаружение необходимых элементов файла (ссылка, логические части текста и т.п.).

- Парсить можно выдачу на предмет позиций ресурса, можно страницы на предмет нахождения там нужной ссылки и т.п.

- Песочница — это одно из самых серьезных препятствий, которое необходимо преодолеть новому проекту, прежде чем попасть в результаты поиска русского Google. Песочница Google не позволяет новым ресурсам искусственным путем улучшать свои позиции. Далеко не каждая поисковая система имеет подобную фильтрацию. Сайты, оказавшиеся в песочнице, могут пробыть там от двух недель до года. В течение этого периода новые проекты успеют занять высокие позиции в других поисковиках, но не в Google.

SEO умерло? Нет, просто вы не умеете его готовить

Сегодня хочу выступить в роли адвоката Сео методов продвижения и попытаться объяснить основные причины, по которым возникают проблемы у тех, кто пытался или пытается понравится поисковым системам с целью получить от них в ответ поток целевых посетителей на свой сайт. На самом деле, набор ошибок получается довольно стандартным (большинство их совершают), но именно очевидные вещи зачастую ускользают от внимания.

Последнее время SEO серьезно эволюционировало и закупка ссылок теперь стоит далеко не на первом месте. Да что там ссылки, даже внутренняя оптимизация сайта уже не имеет решающего значения в успехе продвижения. Особенно это касается коммерческих сайтов, где поисковики используют довольно-таки специфические факторы ранжирования, которые могут показаться неожиданными. Какие именно? Думаю, что при внимательном прочтении данной статьи вы сможете получить ответ на этот и ряд других не менее важных вопросов.

Сейчас по-настоящему разобраться в SEO довольно сложно, ибо почти вся информация, имеющаяся в паблике (статьи, конференции, форумы и т.п.) огромна по своим размерам, но крайне не содержательна. Почти все, что вам может встретиться — это сплошная вода, общие фразы и принципы, которые уже давно не работают. Те, кто в продвижении сайтов действительно разбираются, активно зарабатывают на этом и мало делятся информацией (их время стоит дорого).

Тоже самое можно сказать и про подавляющее большинство платных курсов (вне зависимости от их стоимости) — они по большей части не представляют никакого практического интереса. В SEO кампаниях также ощущается огромный дефицит специалистов, и большинство из работающих там людей умеют лишь закупать ссылки (или предлагать удаленную работу фрилансерам).

Из-за этого авторитет Сео-продвижения сильно подрывается, и уже кажется, что все это сплошное шарлатанство (оптимизаторы не отвечают за результат, ибо его нельзя гарантировать априори, да и дорого все это — хотя контекст бывает в разы дороже). На самом деле тут и кроется основная ошибка, которая в итоге очень сильно подрывает авторитет SEO. Пытаясь продать свои услуги, Сео-конторы и фрилансеры обещают все что угодно (зачастую совершенно нереальные вещи), лишь бы клиент «поплыл».

На самом деле, даже если вы не верите в возможности поискового продвижения, то это не значит, что эту тему не следует изучать. Это необходимо хотя бы для того, чтобы исправить элементарные ошибки в работе сайта (например, те, о которых я писал в статьях про зеркала и дубли страниц на сайте, а также про Http ответы сервера и редиректы).

Но кроме этого существует еще масса «граблей», на которые наступают очень многие владельцы интернет-проектов. Это мешает естественному продвижению вашего сайта в поисковых системах, а также не позволяет получить результаты при намеренном продвижении, ибо сводит все усилия на нет. Ошибка может заключаться даже в самом подходе к продвижению, ибо он должен состоять из последовательного выполнения некоторых базовых действий, которые не желательно пропускать или менять местами.