Фильтры Яндекса и Гугла — за что сайт может получить пессимизацию или бан от поисковой системы

Здравствуйте, уважаемые читатели блога KtoNaNovenkogo.ru. Эта статья является логическим продолжение публикации на тему повышения релевантности и улучшения ранжирования, с которой вы можете ознакомиться по приведенной ссылке. Сегодня я хочу поговорить о фильтрах, которые имеют место и в Гугле, и в Яндексе, а так же поделиться собственным примером попадания под один из них.

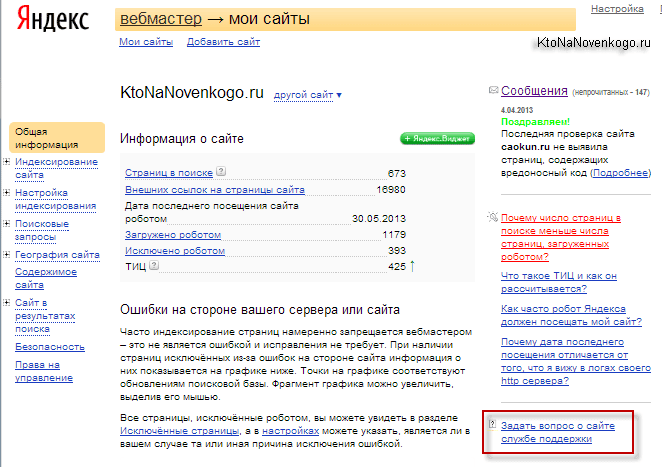

На самом деле оптимизация сайта под поисковые запросы — это, по большому счету, ходьба по лезвию бритвы. Причем все те действия, что совсем недавно не вызывали у российских поисковиков никаких нареканий, могут с течением времени стать причиной наложения фильтра или даже попадания в бан. Во второй половине статьи я опишу свою печальную историю об общении с техподдержкой Яндекса на предмет попадания KtoNaNovenkogo.ru под фильтр за переоптимизацию, ну, а пока немного теории.

Виды и причины санкций (фильтров) Яндекса

К сожалению, даже выполняя все приведенные ниже предписания, вы не будете на сто процентов застрахованы от пессимизации, но риск снизится существенно. По любому, понимая механизм наложения фильтра, вы сможете сами понять за что вас наказали и постараться устранить существующие недочеты.

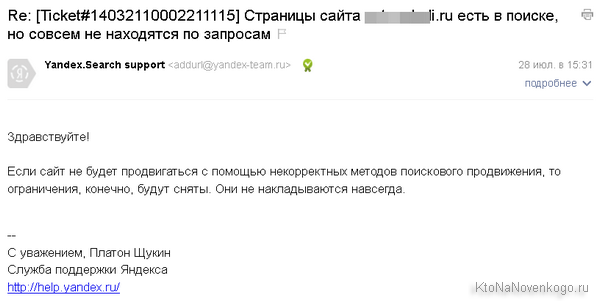

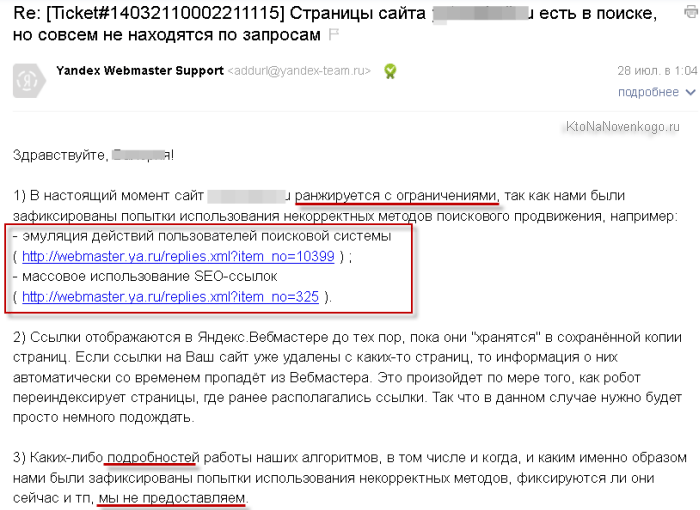

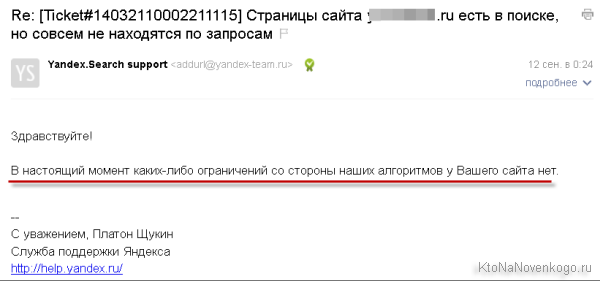

Консультации с Платоном (обычно, обезличенный человек, отвечающий вам на вопрос заданный в техподдержку Яндекса, подписывается Платон Щукин, ну, или раньше так было, по крайней мере) тоже будет проще вести, понимая принципы наложения баннов.

Итак, все фильтры Яндекса, опираясь на принцип работы поисковых систем и используемые ими методы ранжирования, можно разделить на:

- Предварительные фильтры — их поисковик применяет еще на этапе попадания сайтов в индекс и базовый поиск. Типичным примером может являться не учет большинства попыток накрутки поведенческих факторов.

- Постфильтры — налагаются уже после расчета релевантности документа (ранжируемой веб-страницы)

Санкции накладываемые Яндексом можно разделить также на:

- Ручные

- Автоматические

А еще по степени и типу ущерба можно выделить:

- Полный бан (сайт забанен), т.е. произошло исключение всех страниц из поисковой базы. Естественно, что при этом трафик с этого поисковика прекратится полностью.

- Возможен фильтр в виде неучета исходящих ссылок с ресурса. Он может быть важен, например, для тех, кто планирует купить с него ссылки.

- Возможен и неучет входящих ссылок, что будет серьезно ухудшать ранжирование.

- За агресивную рекламу или имеющийся контент для взрослых вас могут ограничить в поиске (например, во втором случае показываться вы будете только при выборе пользователем, ищущим что-то в Яндексе варианта «без ограничений»).

- Пресловутый АГС, который приводит к исключению из поисковой базы части страниц ресурса (зачастую большую часть).

- Наказание за выявленную попытку накрутки поведенческих факторов (будем говорить подробнее чуть ниже).

- Еще ряд фильтров и санкций, которые накладываются после ранжирования.

Какие причины могут приводить к наложению санкций?

- Тексты запросто могут приводить к наложению фильтров. Например, у меня это был фильтр за переоптимизацию контента.

- За ссылки тоже могут покарать. Например, за неумелую и неумеренную работу по набору внешней ссылочной массы или за переоптимизацию при организации внутренней перелинковки.

- За злоупотребление рекламой, размещенной на страницах ресурса, тоже может последовать наказание.

- Понятно, что и какие-то попытки накруток (ПФ и т.п.) могут привести к печальным последствиям.

- Могут выявить ваши аффилированные сайты — созданые для продвижения услуг или товаров одной и той же компании с целью занятия как можно большего числа позиций в выдаче (по большинству поисковых запросов в выдаче будет представленного только по одному результату с одного ресурса).

За что можно получить бан (пессимизацию сайта, фильтр) в Яндексе?

Давайте начнем с самого радикального наказания Яндексом простых веб-мастеров, а именно с вещей, которые могут привести к попаданию сайта в бан (так называемое черное SEO).

- Скрытый текст — белым шрифтом по белому фону или использование еще каких-либо методов размещения контента, который обычные посетители не видят. Бан можно получить, например, и за использование для скрытия текста CSS свойства Display none.

- Размещение на страницах списка ключевых слов, под которые они продвигаются. Наверное, встречали (раньше это было распространено) оформление этого списка в виде блока «Нас еще искали по запросам». Однако, могут наказать (баном или фильтром) даже за обычную перелинковку, где вы усердно ссылаетесь на другие страницы с использованием ключей (например, по стуку от конкурентов). В этом плане довольно опасно перебарщивать.

- Клоакинг — это когда поисковым роботам (их узнают по юзернейму, которым они представляются при заходе на сайт или Ip адресу) выдает одни контент (как правило, переоптимизированный и трудночитаемый), а посетителям совершенно другой (без лишних ключей и вполне себе лаконичный). Клоакинг активно использовался на заре становления поисковых систем, когда те еще не наказывали за спам ключами и т.п. вещи.

- Ссылки с картинки размером в один пиксель, которую, естественно, на сайте не видно, но ссылку-то поисковик видит и учитывает. Опять же это рудимент из прошлого, который сейчас разве что только совсем дремучий вебмастер будет использовать.

- Контент созданный автоматически, например, в доргене (движке дорвея) или синонимайзере. Эти вещи по-прежнему активно используются, и дорвейщики умудряются до сих пор обходить препоны поисковиков. Жизнь доров не долга, но сил на их создание особо не тратится, поэтому они берут количеством и глубоким изучением меняющихся алгоритмов поисковиком и попыткой сыграть на их уязвимостях.

- Наличие на сайте страничек или разделов для обмена ссылками (созданных вручную или автоматически) или любых других структур, которые можно отнести к разряду линкопомоек (сотни и тысячи ссылок на разные ресурсы). Причем не важно, будут ли линки проставлены с текстовым анкором или они будут идти с баннеров или картинок. Все это прямой путь в бан Яндекса, либо (если повезет) к наложению санкций. Причем меняться ссылками можно, но они должны быть тематическими вашему ресурсы и в небольшом количестве.

- Размещение веб-страницы как бы вне сайта, ибо на них нет внутренних ссылок (только внешние) с вашего ресурса и они не упоминаются в sitemap.xml. Выполнены они при этом могут быть в дизайне сайта и иметь все те же самые элементы навигации.

Если на вашем ресурсе что-то из описанного выше имеется (может быть даже и без злого умысла созданное), то лучше это быстренько пофиксить.

От бана давайте перейдем к более мягким мерам наказания используемых Яндексом, а именно к фильтрам. Наличие многих из них официально подтверждены этой поисковой системой, а часть является досужим домыслом оптимизаторов, но это вовсе не говорит о том, что они не используются (помните как в ДМБ: «Ты суслика видишь? — Нет. — И я нет. А он есть!»).

Все описанное выше было бы очень здорово, если бы у поисковиков не было такой вещи как пессимизация и фильтры, которые способны существенно понижать в выдаче даже высоко релевантные запросу сайты. Для чего нужны поиску эти инструменты?

Ну, очевидно, что для отсева различных вариантов накрутки и переспама описанных чуть выше факторов ранжирования. Те же самые тексты можно так забить ключевыми словами для якобы повышения соответствия поисковому запросу, что на документ будет наложен соответствующий фильтр, позволяющий алгоритму исключить такой документ из индекса или же серьезно понизить его релевантность. Тоже самое относится и к переспаму анкор листов и накрутке поведенческих факторов.

Пессимизация и фильтры (или бан) — это инструменты поисковых машин для борьбы с накрутками и спамом. Они последнее время очень сильно нацелены на то, чтобы бороться с попытками манипуляций с факторами продвижения и попытками улучшения значения формулы релевантности для своего ресурса.

Поисковики стараются не допускать и бороться с искусственным воздействием на формулу и все используемые ими способы пессимизации можно разделить на две категории:

Фильтры, накладываемые еще до начала построения формулы ранжирования для вашего сайта. В этом случае поисковики снижают влияние или полностью обнуляют для вас некоторые факторы, тем самым существенно снижая ваши шансы попадания в Топ выдачи. Например, при активных попытках манипуляции с входящими ссылками, могут обнулить значение ссылочных динамических факторов (ссылочное или анкорное влияние) для вашего ресурса (не учитывать ссылки вообще).

После наложения такого предварительного фильтра, тем не менее, к вашему ресурсу будут применяться стандартные формулы ранжирования, но за счет нулевого (или пониженного) значения одного из факторов, место вашего сайта в поисковой выдаче будет не соответствовать реальной релевантности документа. Пессимизация во все красе.

- Есть фильтры, которые накладываются уже после того, как для сайта будет рассчитана формула. Но вследствие наложения фильтров рассчитанная релевантность будет понижена на определенную величину, т.е. от полученного значения для определенного документа вычитается некий штраф. К данному типу фильтров можно отнести так называемый «портяночный фильтр» Яндекса, который за переспам ключевых слов в контенте опускал ресурс довольно сильно в результатах поиска.

Давайте рассмотрим несколько примеров, показывающих, за что могут быть наложены фильтры (пессимизация):

Аффилированность сайтов — иногда оптимизаторы (или владельцы бизнеса) идут на то, чтобы захватить как можно больше мест в Топе поисковой выдачи и тем самым перехватить как можно больше целевых посетителей (потенциальных клиентов). Сделать это не так то просто, т.к. в результатах поиска обычно отображается только один документ с каждого ресурса (наиболее релевантный запросу). Но выход есть.

Создается еще один или несколько ресурсов помимо основного и их тоже начинают усилено продвигать по тем же поисковым запросам. В результате, в Топе результатов поиска может присутствовать несколько сайтов одного и того же владельца (фирмы). Поисковикам такая ситуация не нравится и при обнаружении такой попытки повлиять на ранжирование, они накладывают фильтр за аффилированность, в результате действия которого в выдаче остается только один ресурс, а остальные начинают считаться его зеркалом.

Что примечательно, этот фильтр работает не всегда корректно и именно благодаря ему появился способ борьбы с конкурентами, который позволяет убедить поиск в том, что ваш сайт аффилирован с ресурсом вашего конкурента, но поиск предпочтет, в силу ряда причин, оставить в выдаче именно ваш ресурс, выкинув конкурента не только из Топа, но и вообще из результатов поиска по данному запросу.

Фильтр на одинаковые сниппеты — если у нескольких сайтов в результатах поиска по определенному запросу будут до некоторой степени одинаковые сниппеты, то будет показываться только один из них. Причем, не факт, что останется более релевантный документ.

Наверное, данный фильтр наиболее актуален для интернет магазинов, которые зачастую имеют одинаковые описания товаров (а они могут использоваться в качестве сниппета) взятые с ресурсов производителей.

- Фильтры за качество контента

Портяночный фильтр — переоптимизированные тексты, где чрезмерно высоко количество употреблений ключевых слов. Этот фильтр зависит от конкретных запросов (в основном применяется к коммерческим) и на его наложение или неналожение может повлиять авторитетность ресурса.

Например, в случае коммерческого запроса и пятидесяти вхождений ключа в тексте документа, вы гарантированно попадаете под портяночный фильтр и релевантность вашего документа уменьшится на величину штрафа (кстати, очень большого, способного отбросить ресурс за первую сотню в выдаче).

Для того, чтобы исключить наложение портяночного фильтра, достаточно будет:

- избегать многократного употребления ключевых слов (не более пяти десятков в документе, а лучше половину от этой цифры)

- не допускать концентрации ключей в конце текста (фильтр был направлен именно на Seo тексты, где все ключи собирались в самом конце текста, до которого никто из посетителей не доходил)

- не допускать высокой концентрации ключевых слов в отдельных фрагментах текста, т.е. распределять их как можно равномернее

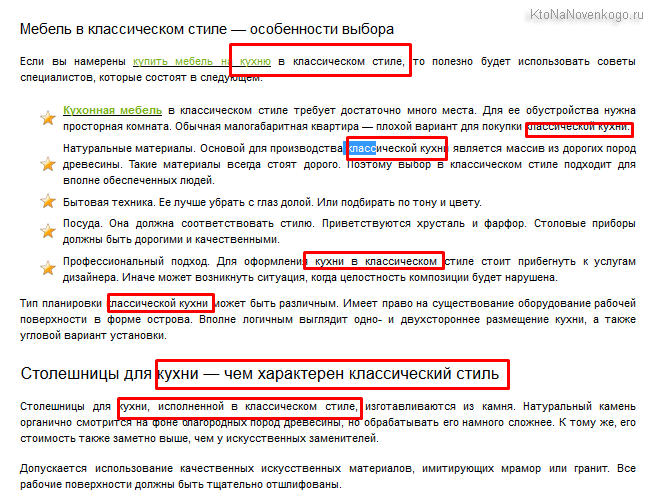

Фильтр за переоптимизацию — направлен против манипулирования текстовыми факторами ранжирования и попытки оказать влияние на релевантность документа. Отличается от портяночного тем, что штраф накладывается не за количество употреблений ключевых слов в тексте.

Данный фильтр применяется практически исключительно для коммерческой выдачи и не привязывается к конкретному поисковому запросу, т.о. если он накладывается на документ, то веб страница понижается по всем запросам, по которым она продвигалась. Причем, штраф (пессимизация) при наложении этого фильтра будет меньше, чем при наложении портяночного (пару десятков позиций, т.е. просто выкидывается сайт из топа)

- Фильтры за вторичность (использование копипаста) контента

- Фильтры за качество входящих ссылок

- Ссылочный взрыв — данный фильтр налагается тогда, когда резко увеличивается ссылочная масса ведущая на сайт. Он присутствует и в Яндексе, и в Google, причем в Гугле пессимизация за ссылочный взрыв для молодых ресурсов даже более актуальна. Поэтому, если ресурс вообще еще не обладает ссылочной массой, следует ограничиться приростом бэклинков, скажем, не более десяти в неделю.

- Большое количество ссылок с плохих и ненадежных, с точки зрения поисковых систем, ресурсов может привести к проблемам с ранжированием (наложению фильтра). К вопросу о пользе автоматического прогона по десяткам тысяч ГС каталогов — несколько ссылок пойдут в плюс вашему сайту, а вот остальные могут утянуть его под фильтр за некачественную ссылочную массу и, как следствие, понижение в выдаче (пессимизация).

Покупные Seo ссылки — поисковики умеют определять покупные бэклинки с большой долей вероятности, но коммерческие ссылки не всегда есть зло с точки зрения поиска, ибо зачастую проставляются они с качественных и авторитетных ресурсов. Покупные линки по коммерческим запросам могут положительно влиять на ранжирование и увеличивать релевантность документа.

Другое дело, когда вы попытаетесь продвигать информационные запросы при помощи закупки ссылочной массы, то это будет просто пустая трата денег и времени. Получается своеобразный запросозависимый ссылочный фильтр.

- Участие в линкаторах (автоматических биржах по обмену ссылками) тоже может привести к наложению фильтра и, как следствие, к понижения в выдаче.

За что еще пессимизирует сайты Яндекс

В разделе «Основные принципы» говорится о том, какие ресурсы он хотел бы видеть в своем индексе. Тут нас «агитируют за советскую власть» — советуют использовать только оригинальный контент, продумывать юзабилити, не проставлять ссылки на страницах своего проекта за деньги, а так же думать прежде всего о посетителях (т.е. создавать нужно именно СДЛ) и не пытаться продвигаться по тем поисковым запросам, по которым на страницах нашего ресурса не будет исчерпывающей информации. В общем-то, справедливо, но...

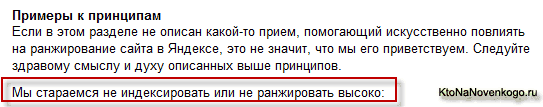

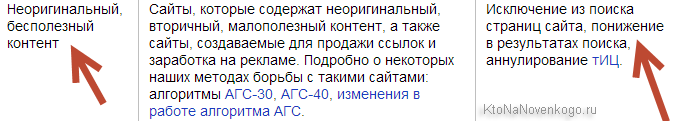

Наверное, это все интересно, но гораздо интереснее то, что написано в разделе «Примеры к принципам» после слов «Мы стараемся не индексировать или не ранжировать высоко».

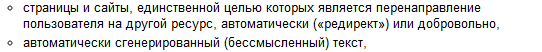

В первом пункте Яндекс предупреждает, что за не уникальный (скопированный) контент ресурс может быть пессимизирован.

Наверное, небольшой процент не уникального контента не приведет к печальным последствиям, но при переходе определенной грани можно попасть под фильтр и сильно потерять в позициях в выдаче, несмотря на то, что релевантность страниц вашего сайта будет достаточно высокой.

Следующие два пункта кидают камень в огород так называемых дорвеев или доров.

Несколько лет назад было довольно популярным занятием создавать дорвеи, тексты страниц которых генерировались автоматически с простановкой нужного количества ключевых слов. Таким образом эти дорвеи попадали в Топ выдачи по нужным ключевым запросам, но пользователи, переходящие на доры из поисковиков, не видели этот автоматически генерированный бредо-текст, т.к. их автоматически перебрасывало на страницы совершенно другого ресурса, продвигаемого таким образом.

Этот способ продвижения относится к так называемому черному SEO. Сейчас двигаться с помощью дорвеев очень сильно затруднено в связи с очень серьезным отношением к этой проблеме поисковых систем. Доры попросту долго не живут и умирают, так и не успев попасть в Топ поисковой выдачи. Однако, их все равно продолжают клепать, дорвеестроители стараются всегда найти лазейку во все еще довольно крупноячеистой сети поисковиков, в которой они отлавливают кандидатов на отправку в бан или под фильтр.

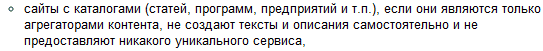

Дальше Яндекс предупреждает, что в ранжировании будут понижаться сайты, имеющие в своем составе каталоги чего угодно, которые не содержат какой-либо уникальной информации.

В связи с этим становится ясно, что продвижение с помощью прогона по каталогам, которое было популярно несколько лет назад, сейчас уже не работает в силу нахождения всех этих каталогов под фильтрами Яндекса (они искусственно занижены в ранжировании, несмотря на реальную релевантность их страниц). В общем, не создавайте сами ГС каталоги и не прогоняйте по ним свои ресурсы, ибо это абсолютно бесполезно (если не вредно).

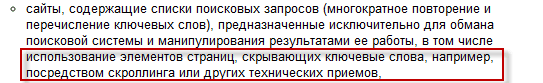

Далее следует уже банальность — в выдаче будут понижены ресурсы с невидимым или слабо видимым текстом (белым по белому и т.п.) и ссылками.

Понятно, что если вы чего-то прячете от посетителей (например, портянку текста, напичканную ключевыми словами), то несмотря на высокую релевантность этой страницы продвигаемому запросу, Яндекс все равно не позволит ей высоко подняться в выдаче.

Чуть ниже вы сможете узнать, что даже заключая большой текст с ключами в окошко со скролингом, вы все равно потеряете в позициях за счет попадания под фильтр и последующую пессимизацию (пару лет назад это стало громом среди ясного неба для многих профессиональных сеошников).

Затем он предупреждает нас о недопустимости использования еще одного приема продвижения из области черного SEO — клоакинг.

При использовании клоакинга сайт программируется таким образом, чтобы определять, кто именно осуществляет запрос данной веб страницы — поисковый робот или же браузер пользователя (сделать это не сложно на основе анализа запроса к веб серверу). Соответственно, боту отдается веб страница релевантная нужному запросу, а реальному пользователю показывается совершенно другое содержимое.

В очередном примере того, чего не нужно делать, чтобы не попасть под фильтр, Яндекс предупреждает о недопустимости создания ресурсов, которые предназначены лишь для того, чтобы «лить трафик» на вебсайт какой-либо партнерской программы.

Очень часто этим занимаются в так называемой «фарме». Несмотря на высокую релевантность страниц таких ресурсов они будут серьезно пессимизированы. Хотя, многие на этом живут, с успехом обходят все препоны, которые расставляют поисковики на их пути, и их сайты не попадают под фильтр.

Читая данную «декларацию о намерениях» дальше вы узнаете, что поисковикам не нравятся сайты с вирусами и прочими хитрыми заморочками в настройках серверов, такие ресурсы будут нещадно пессимизироваться невзирая на реальную ценность их страниц для поиска.

Равно, кстати, как и ресурсы, использующие агрессивные способы рекламы с всплывающими окнами (popup, popunder, clickunder). Лично я только за расстрел таких ресурсов из оружия крупного калибра, ибо понижение в выдаче для них уж слишком мягкое наказание — бан и никак не меньше. Вот такой вот я злой, ибо до того как стать вебмастером, я был обычным пользователем и потратил много нервов (сдерживался, чтобы не врезать кулаком по монитору) на подобные сверх раздражающие вещи.

Довольно часто раньше встречался на многих сайтах такой вид спама — «нас находили по таким-то поисковым запросам» и далее следовал список этих самых запросов. Веб сервер собирал эту информацию и выкладывал на данной веб странице запросы в чистом виде, тем самым существенно искусственно повышая релевантность этой страницы.

Вот я раньше попадая на такую страницу очень долго гадал, а чего это меня поисковик на нее привел, когда там нет ответа на мой вопрос (даже намека нет), а только перечисленные фразы, включая ту, которую задавал и я в поисковой строке. Естественно, что такая изгаженная выдача не нравится никому (поисковики теряют на этом лояльных посетителей) и начинают понижать в ранжировании такие ресурсы, загоняя их под фильтры или даже в бан (полное удаление из индекса).

Плагины и расширения, реализующие такой вид спама для увеличения релевантности страницы, можно встретить и сейчас, но упаси вас воспользоваться ими — ни в коем разе, ибо сразу пессимизируют и так понизят в выдаче, что трафика с поисковиков вообще не будет.

Но что обидно, иногда под этот фильтр можно попасть за использование совершенно, казалось бы, безобидного «облака тегов», если поисковик сочтет его за такой вид спама и стремление искусственно повысить соответствие страницы запросам поиска.

Далее Яндекс предостерегает нас от создания нескольких ресурсов для одного владельца (аффилированность):

Есть такой хитрый способ оккупации всего топа поисковой выдачи за счет создания целой когорты сайтов для одной и той же фирмы, которые делаются на разных доменных именах и наполняются разным контентом, с высокой релевантностью нужным запросам. В результате продвижения их выталкивает в топ выдачи Яндекса и Гугла и, в случае большой удачи, весь Топ 10 может быть заполнен ресурсами одной и той же фирмы.

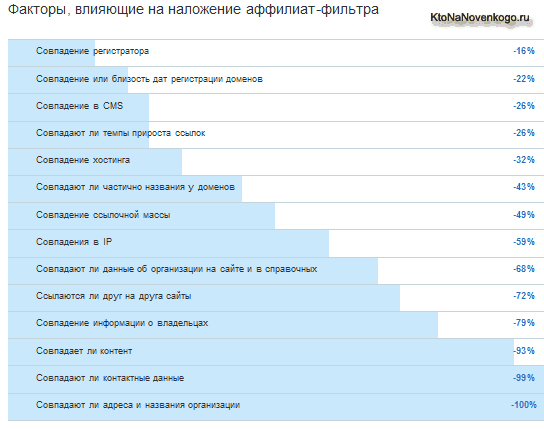

Для данной фирмы это будет неоспоримая удача, но поисковикам такая ситуация кажется неправильной и они всеми силами и средствами пытаются выявить и понизить в выдаче такие дубликаты (аффилиаты). Обычно аффилиаты палятся (попадают под аффилиат-фильтр) на одинаковых контактных телефонах и других признаках принадлежности одному владельцу, но гораздо чаще по «стуку» конкурентов.

Понятно, что поисковикам не интересны спамные форумы и доски объявлений, где любой посетитель может написать все что угодно и поставить любую нужную ему ссылку, и они будут нещадно понижать в ранжировании и фильтровать вплоть до полного исключения из индекса (бана).

Яндексу, равно как и другим поисковикам, очень не нравятся ресурсы, продающие ссылки для накачки релевантности других ресурсов. Продажные ссылки портят стройный алгоритм ранжирования, основанный на ссылочном факторе.

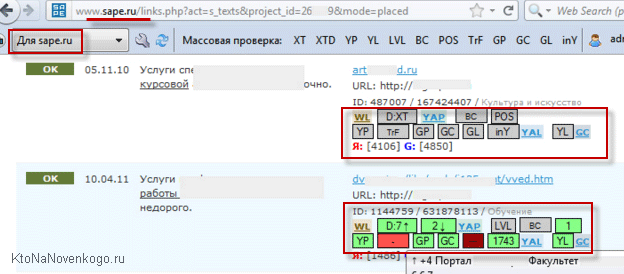

Однако, основному риску попадания под фильтр или в бан подвергаются ресурсы, устанавливающие скрипты бирж ссылок типа Sape, в то же время, как продавать ссылки через «биржи вечных ссылок», подобные описанным ниже, можно практически безболезненно и ничем не рискуя.

- ГоГетЛинкс — здесь читайте о нюансах работы с ним

- РотаПост — здесь полный обзор возможностей биржи

Довольно часто, особенно несколько лет назад, для продвижения проектов и получения внешних ссылок использовали так называемые «сателлиты», т.е. группа сайтов, которая создается только лишь для продвижения одного или нескольких ресурсов, путем проставления на него ссылок. Такие вещи сильно не нравятся поисковикам, т.к. создается искусственная накрутка релевантности и сетки сателлитов довольно эффективно выявляют и отправляются под фильтр или в бан.

Практически на любом ресурсе будет присутствовать внутренний поиск. Он может быть реализован средствами используемого движка, а может быть прикручен с помощью скрипта поиска по сайту от Яндекса, либо от Гугла. Но в любом случае страницы с результатами поиска по материалам вашего ресурса не должны попадать в индекс поисковых систем во избежании наложения фильтра.

Как это сделать? Ну, у нас всегда есть под рукой очень сильный инструмент по управлению индексацией сайта — robots.txt.

Фильтр АГС (17, 30 и 40) от Яндекса

АГС (антиго*носайт) — бывают разновидности с номерами 17, 30 и 40. Опасаться этого фильтра стоит прежде всего тем, кто на потоке создает ГС (сайты, созданные под поисковые системы или для продажи ссылок, но никак не на благо посетителей). Появился этот тип пессимизации в 2009 году, а его последняя модификация АГС 40 датируется концом 2013 года. Как уже понятно из названия, фильтр этот призван выкашивать из выдачи некачественные ресурсы, а его новые версии связаны с повышением его избирательности.

После его наложения в индексе Яндекса остается обычно всего несколько страниц (от одной до десятка). При этом оставшиеся в индексе страницы какой-либо дополнительной пессимизации не подвергаются (их позиции в выдаче остаются неизменными). Работает АГС, естественно, в автоматическом режиме.

Давайте рассмотрим некоторые критерии, по совокупности которых повышается вероятность попасть под фильтр АГС Яндекса:

- Недавно зарегистрированное доменное имя (молодой сайт)

- Размещение ресурса на бесплатном хостинге

- Использование какой-либо версии бесплатного движка сайта (Joomla, WordPress, взломанная DLE и т.п.).

- Низкая или практически нулевая посещаемость (несколько человек в день). По существующей статистике можно сделать выводы, что если посещаемость составляет менее полусотни человек в сутки, то вероятность попадания сайта под АГС Яндекса весьма высока. А вот если посещалка перешагнет порог в три сотни уникальных посетителей, то подхватить АГС станет очень трудно выполнимой задачей. Как узнать и отследить статистику посещаемости читайте в приведенной публикации.

- Отсутствие ресурса в трастовых каталогах типа Яндекса или Дмоза. Попав в оба эти каталога, вы сможете себе гарантировать практически неприкосновенность в отношениях с АГС. Об этом говорит анализ тех ресурсов, которые под этот фильтр угодили.

- Отсутствие или малое количество внешних ссылок, ведущих на этот ресурс. Для ликвидации этого пробела без допущения перегибов советую ознакомиться с материалами:

- Наличие форумов, блогов или досок объявлений (на том же домене или поддомене), на которые информация добавляется всеми желающими без модерации. Обычно в результате создается чудовищная спам-помойка, которая сильно дискредитирует данный ресурс.

- Многократное дублирование внутреннего контента (например, для получения большего числа страниц, с которых можно продавать ссылки). В WordPress это могут быть архивы меток, рубрик, временные архивы и т.п. вещи.

- Наличие на сайте в больших количествах не уникального контента или текстов плохого качества (низкопробный рерайт или автоматически сгенерированные тексты).

- Слишком агрессивная внутренняя перелинковка страниц с большими блоками внутренних ссылок. В этом плане, многие советуют быть осторожнее с такими вещами, например, как облако тегов.

- Присутствие признаков продажи ссылок (наличие внешних ссылок на многих страницах сайта).

- Наличие агрессивной рекламы типа всплывающих или выезжающих окон, а также некоторых видов тизеров (тизерной рекламы). Уважающий себя и своих читателей ресурс, как правило, такие вещи не будет использовать.

Как вывести сайт из под АГС (17, 30, 40)?

Однако, если вы уже попали под этот вид пессимизации, то вас в первую очередь будут интересовать методы выхода из под фильтра АГС. По сути, это универсальные рекомендации, помогающие понять то, что произошло с вашим сайтом, когда вы заметили уменьшение трафика с поисковой системы Яндекс.

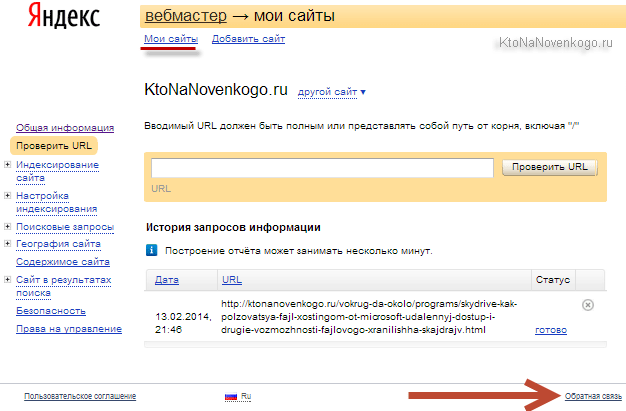

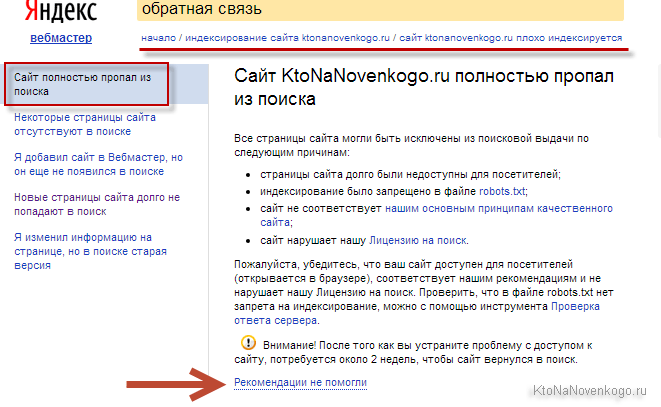

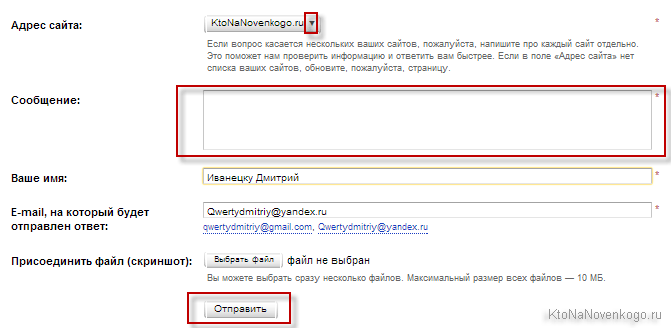

- Естественно, что начинать нужно с «письма Платону», или, другими словами, попробовать связаться с поддержкой Яндекса для выяснения причины. Ни в коем случае не качайте права, а просто объясните ситуацию и попросите совета. Мою переписку с Платоном по поводу фильтра за переоптимизацию можете посмотреть по ссылке.

- Если после ответа Платона или по своем собственному разумению вы поймете, что дело в контенте (а именно в его низком качестве или переоптимизации), то ничего другого не останется, как переписать контент. Понятное дело, что будь ваш ресурс реальным ГС вы этого делать не будете в силу нецелесообразности (проще новый ГС сляпать), а вот при попадании под АГС действительно вашего детища, которое вы холите и лилеете, можно будет и напрячься.

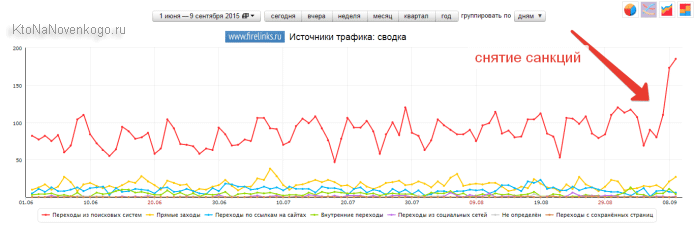

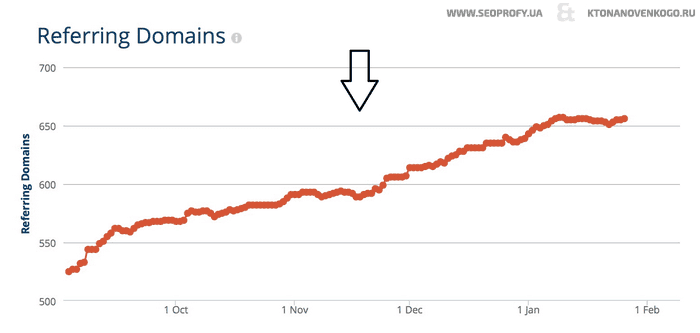

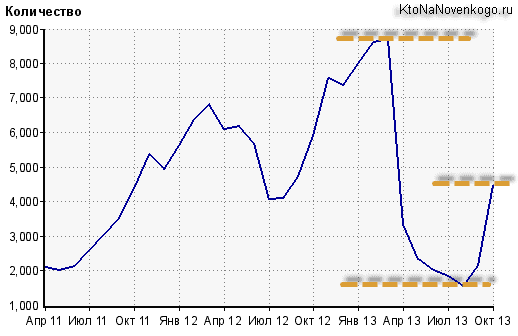

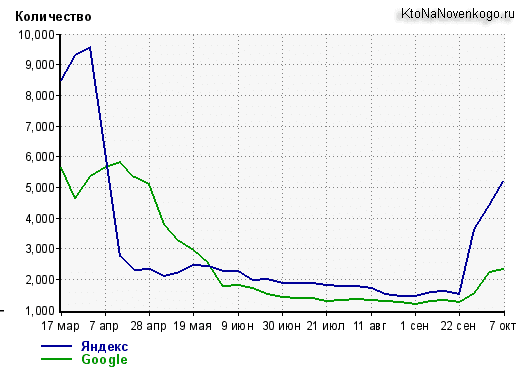

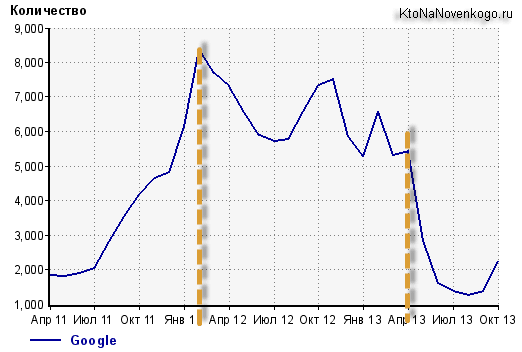

Правда, у меня это вылилось в пять месяцев каторжной работы по переделке четырех сотен статей, но фильтр Яндекса за переоптимизацию был снят, поэтому овчинка стоила выделки. Методику работы с текстами вы можете почерпнуть отсюда:

- Если вы вкупе с бесплатным движком используете еще и бесплатный шаблон, который одновременно юзают еще тысячи ресурсов в сети, то имеет смысл попробовать сменить дизайн на более уникальный.

- Если создаваемый вами сайт позиционируется как коммерческий, то обязательно добавьте на него контактные данные (телефон, адрес офиса, схему проезда), четко обозначив какой именно организации он принадлежит. Асессоры Яндекса, кстати, могут проверить реальность контактных данных, так что... Очень многие ГС маскируются под коммерческие ресурсы, но именно отсутствие контактов их выдает. Для информационного ресурса добавьте контактный Емайл или вставьте на страницу контактов форму для обратной связи.

- Попробуйте добавить на свой сайт какой-то полезный сервис. Например, стандартом для многих ресурсов коммерческой тематики является наличие калькуляторов для расчета стоимости услуг или чего еще либо. Подсмотреть это дело можно у конкурентов.

- Если есть подозрение, что юзабилити и навигация по сайту хромают, то не примените это поправить. А вообще, прочитайте статью про «Пять основных ошибок при продвижение коммерческого сайта» и сделайте для себя выводы о несоответствии вашего проекта стандартам современного SEO, чтобы АГС даже и рядом не стоял.

По сути, все приведенные выше советы по выходу из под АГС сводятся к одному: делайте сайты для людей — с нормальным дизайном, с нормальным отформатированным контентом и удобной навигацией (юзабилити). Совет простой, но на его выполнение придется потратить уйму времени (либо денег).

Санкции Яндекса за контент (тексты)

Текстовые фильтры можно разделить на два основных типа, которые приведены и описаны ниже. Выход из под них будет несколько отличаться, но общей чертой является оптимизация контента под текущие требования SEO, а не под то, что рулило десяток лет тому назад.

Портяночный фильтр

Фильтр за переспам или портяночный, который был введен в 2010 году и никак Яндексом подтвержден не был (но принцип суслика из ДМБ тут все равно действует). Его отличительной особенностью является проседание страницы по какому-то одному запросу, в то время как другие запросы, по которым эта веб-страница ранжируется, могут остаться на своих позициях.

Методы борьбы с портяночным фильтром достаточно просты: разбавление чистых вхождений просевшего ключевого слова (фразы), уменьшение объема текста (опять же это актуально в большей степени для коммерческих, а не информационных сайтов), а также рулит добавление в текст картинок и форматирования (абзацы, заголовки разных уровней, списки и т.п.). То есть красочно и удобно оформленная «портянка» (даже в десятки тысяч знаков) без засилия ключей с прямым вхождением может потрясающе восприниматься посетителями и потащит запрос вверх.

Под санкции за переспам чаще всего попадают:

- Сильно напичканные ключевыми словами (в прямом вхождении) страницы.

- Тексты длиной в десятки тысяч знаков, которые никто не читает. Ключевым является именно то, что их не читают из-за пугающего размера, отсутствия форматирования и кучи выделенных ключей, вместо каких-то смысловых выделений. Читаемый текст большого объема, наоборот, может являться вполне хорошим подспорьем для продвижения (особенно информационного сайта).

- Кстати, фильтр назвали «портяночным» именно из-за того, что лет пять-семь назад оптимизаторы писали огромные тексты для коммерческих сайтов (без особого форматирования, ибо они писались только для Яндекса и зачастую пряча их от посетителей за спойлерами или в формах без прокрутки), в которые могли легко запихнуть сотни вхождений ключа не превышая критического значения тошноты (процента вхождения ключевых слов относительно общего числа слов в тексте). Поисковики этот метод нечестной оптимизации со временем раскусили и ввели соответствующие наказания за подобную накрутку.

- Кто-то сравнивает тексты моих статей с портянками, но это не правильно, ибо они подпадают под это определение только лишь большими размерами. Да и не так это критично для информационного ресурса (см. википедию, хабрахарбр и другие мейнстримовые информационные ресурсы). Главная проблема длинных текстов — удержать пользователя за их прочтением, чему помогает форматирование, оформление и цепляющие подзаголовки. Ну, и содержание, конечно же, куда ж без него.

Шаги по выходу из под портяночного фильтра (за переспамм):

- Пишем в саппорт Яндекса (да, при этом ваш сайт должен быть добавлен в его панель для вебмастеров) о возможном наложении санкций с попыткой выяснить каких именно.

- Чистим тексты от переспама ключами, а также по ходу удаляем «воду» для уменьшения объема при сохранении сути. Это приведет к лучшему восприятию контента пользователями, особенно вкупе с выполнением условий из следующего пункта.

- Добавляем форматирование, если его не было (разбиение на абзацы по смыслу, добавление подзаголовков, списков, смысловых выделений, картинок, а также по необходимости таблиц или еще чего-то подобного). Это повысит вероятность прочтения текста и приведет к улучшению поведенческих факторов. Другими словами, делаем из портянки конфетку.

- Проверьте, дает ли содержимое страницы ответ на запрос пользователя в полной мере. Это условие тоже нужно соблюдать для выхода из фильтра за переспам.

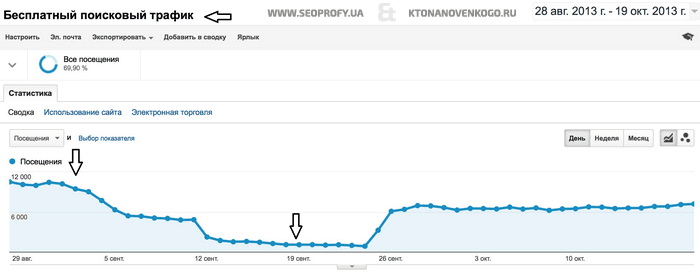

Фильтр за переоптимизацию контента

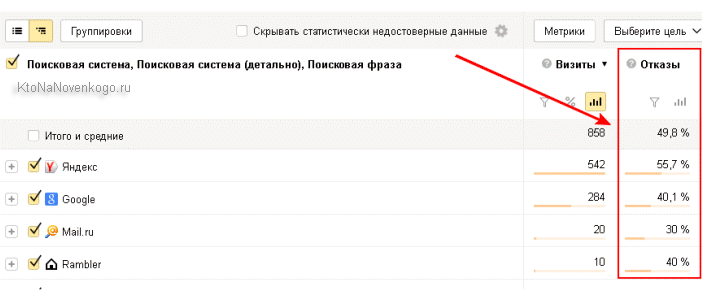

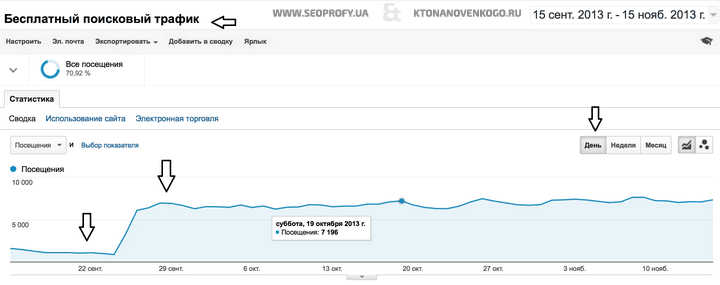

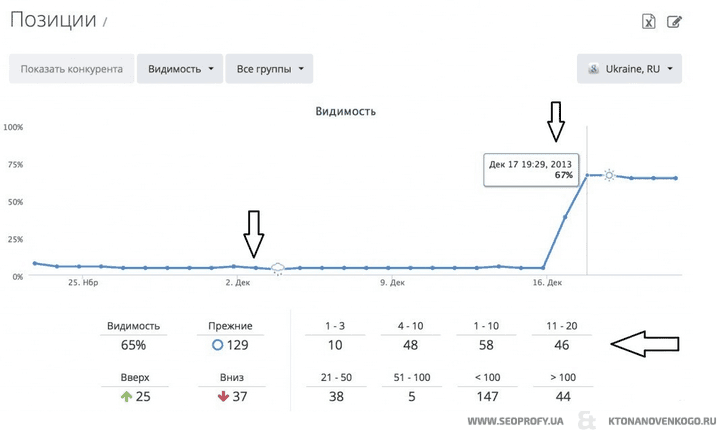

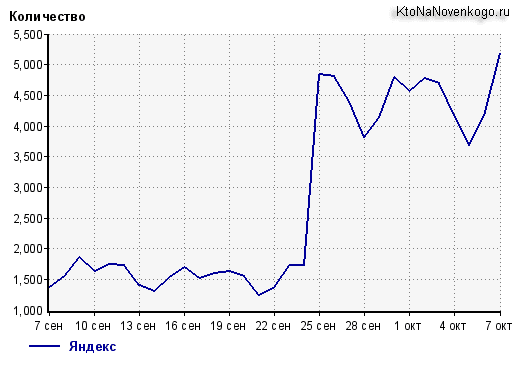

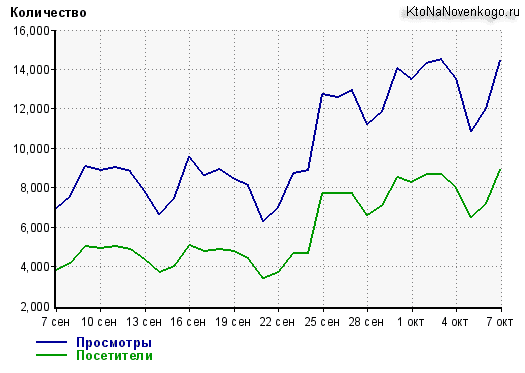

Фильтр Яндекса за переоптимизацию был наложен на мой блог весной 2013 года и всю его прелесть я довольно хорошо прочувствовал на собственной шкуре. Появился же он двумя годами ранее, и его существование было официально подтверждено Яндексом. Отличительной чертой фильтра является проседание не какого-то одного запроса, а всех запросов, по которым ранжировалась (продвигалась) попавшая под фильтр веб-страница (проседают и ВЧ, и СЧ, и даже НЧ и сверх НЧ). В моем случае таких страниц было много и общая потеря трафика была трех-четырех кратной.

Как выйти из под фильтра за переоптимизацию? Ну, во-первых, понадобится полная переписка или существенная корректировка текста тех страниц, которые под этот вид санкций Яндекса угодили. Лично я переписывал все, что у меня было добавлено за первые три года существования блога. Также по ходу этого занятия желательно исправить все имеющиеся орфографические ошибки, расставить знаки препинания и убрать чрезмерное использование тегов акцентирования (b, strong, em), а еще злоупотребления ключами в подзаголовках.

Я еще и тайтлы с альтами из картинок удалил, ибо там ключей было море (это был мой первый шаг еще до переписывания контента, которым я думал по быстрому купировать проблему, но этого оказалось недостаточно, а на восстановление хотя бы альтов рука уже не поднималась в силу масштабности работы). Также я постарался сделать тексты наиболее полезными читателям (выделял ссылки на полезные ресурсы, обновлял устаревшую информацию и удалял «воду»).

Кроме этого хочу сказать, что фильтр Яндекса за переоптимизацию не стоит путать с портяночным, который накладывается лишь только за переспам ключами. Второй из описанных санкционных инструментов накладывается не только за переспам ключами, но и за попытку подсунуть поисковику текст не совсем релевантный запросу, под который он оптимизирован. Такой текст не полностью отвечает на запрос пользователя или не отвечает на него вовсе, хотя и пресыщен нужными ключами.

Зачастую под фильтр за переоптимизацию попадает и бессмысленный контент, содержащий «воду» в океанических масштабах. Примером отсутствия ответа на запрос пользователя может быть оптимизация под коммерческий запрос какого-то товара или услуги, но без указания цен. Или попытка продвинуться по запросу со словом «отзывы», но не предоставляя этих самых отзывов на странице. Такие страницы могут попасть под фильтр Яндекса именно потому, что вы обманываете ожидания пользователя (вашего потенциального клиента).

Симптомы фильтра за переоптимизацию обычно выливаются в резкое проседание продвигаемых на данной веб-странице запросов сразу на десятки позиций вниз. В совсем запущенных случаях может наблюдаться подобное проседание не только отдельных страниц, но и всего сайта целиком (по всем продвигаемым запросам), но без смены релевантных страниц. У меня такого не было, ибо по ряду запросов после наложения фильтра позиции в выдаче Яндекса не изменились. Но шандарахнуло все равно прилично (общий поток посетителей на блог снизился в три раза).

Обобщая все выше сказанное можно дать несколько общих советов по выходу из под текстовых фильтров Яндекса:

- Пишем Платону Щукину (в поддержку Яндекса) для выяснения или уточнения причины снижения потока посетителей, приходящих на ваш сайт с данной поисковой системы. Опять же помните, что ничего не дается нам так дешево и не ценится так дорого, как вежливость.

- Чистим контент от переспама ключевыми словами (процесс может потребовать от вас приложения массы усилий в случае большого объема контента, который надо будет пересмотреть под новым углом зрения).

- Ставите себя не место пользователя, вводящего в поисковой строке запрос, под который вы оптимизировали данную страницу, и пытаетесь понять, дает ли она на него исчерпывающий и всеобъемлющий ответ. В ходе этого может понадобиться обновление устаревшей информации, удаление «воды» и расставление акцентов (выделений) не на ключевых словах, а на важных моментах, за которые должен цепляться взгляд пользователя. Это поможет получить странице хорошие поведенческие факторы и выйти из под фильтра за переоптизацию или переспам контента.

Про рассмотренные чуть выше примеры можно сказать, что нужно будет добавить на страницы цены (либо дать на них ссылку или организовать их вывод во всплывающем окне), если этого ожидает пользователь, вводя свой запрос, или добавить отзывы, если они в запросе упоминаются. В общем, не обманывайте ожидания ваших потенциальных клиентов и они (а вкупе с ними и Яндекс) вами останутся довольны. Все как в реальной жизни.

Повышая релевантность можно попасть в бан

Вот именно о тех неправедных способах повышения соответствия страниц своего сайта требованиям поисковиков, которые могут привести к совершенно обратному эффекту (сильному понижению позиций в поисковой выдачи — наложению фильтра, пессимизации или бану), мы и поговорим в этой статье.

Причем, ничего выдумывать сам я не буду, да и не зачем это делать. Ведь поисковики обязаны прикрыться фанеркой и подробно описать все запрещенные и караемые способы повышения релевантности и воздействия на ранжирование.

В общем, спросим у первоисточника — за что можно получить в лоб, а что можно применять без особой опаски для небольшой корректировки и улучшения позиций сайта в выдаче. Давайте спросим о сокровенном у Яндекса (поддержим отечественного производителя), ибо он все же является лидером в России. Итак, интервью у хелпа Яндекса по поводу допустимых и недопустимых способов улучшения ранжирования.

Хотя, нет. Сначала напомню вам те способы легитимного воздействия на релевантность, о которых я уже неоднократно говорил. Кроме уже упомянутой чуть выше оптимизации текстов под нужные поисковые запросы (Самостоятельная раскрутка и продвижение сайта), наверное, прежде всего стоит сообщить поисковикам о существовании своего веб проекта — добавить Url своего сайта в аддурилку Яндекса и др. поисковых систем.

На ранжирование очень сильно влияет такое понятие, как траст, а поднять его можно обратными ссылками с трастовых ресурсов. Поэтому было бы не плохо попытаться добавить сайт в Яндекс каталог, Dmoz и другие трастовые и авторитетные каталоги. Вообще, все это я уже неоднократно обсуждал и писал, поэтому попробуйте сами поискать ответы в публикации Как раскрутить сайт самому.

Ну, это так, для общего сведения, а сейчас, наверное, пора переходить к перечислению запретных способов манипуляции релевантностью веб документов, в частности, Яндекса. Дело в том, что поисковые системы могут не только повышать или понижать уровень соответствия страниц наших сайтов запросам поиска, но и могут применять санкции и вносить их в черные списки, в случае, если они посчитают, что мы их пытаемся обмануть (описанные выше фильтры и баны).

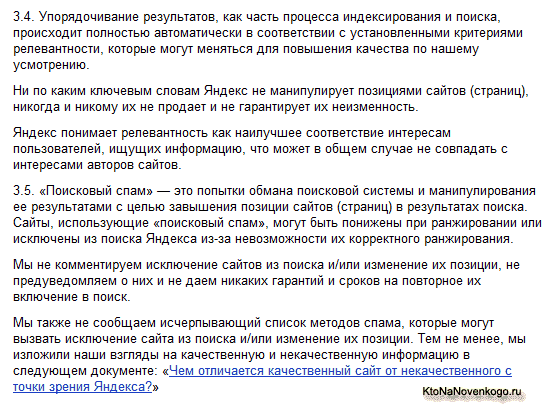

В лицензии поиска такие моменты очень подробно описаны, чтобы к ним не было по этому поводу никаких претензий. Например, в лицензии на использование поисковой системы Яндекса довольно подробно описано про ранжирование:

В первом абзаце лицензии говорится, что оно осуществляется, как и следовало ожидать, на основе определения релевантности страницы поисковому запросу, но делается акцент на то, что она определяется не предвзято с помощью программы, причем, настройки этой программы могут постоянно меняться и, следовательно, ваш ресурс может совершенно спокойно скакать в выдаче с одного места на другое по мере изменения алгоритмов и ничего вы с этим поделать не сможете.

В третьем абзаце пункта 3.4 Яндекс как раз говорит о том, что для него и любой другой поисковой системы главное это интересы пользователя, а не авторов веб проектов (по которым осуществляется поиск), чтобы сразу же в корне пресечь все попытки вебмастеров апеллировать к Яндексу с вопросами о не справедливом и не правильном расчете релевантности по тому или иному запросу (мой ресурс такой хороший, а вы его в конец очереди...).

В первом предложении пункта 3.5 как раз описано то, чем занимаются все SEO оптимизаторы (как начинающие, так и продвинутые) — обманом и спамом (искусственное завышение релевантности страниц для улучшения позиций). При этом Яндекс грозит нам фильтрами (ухудшением позиций — пессимизация сайта), либо вообще баном (полным исключением ресурса из индекса и, соответственно, поиска).

Во втором абзаце этого пункта лицензии написано, что о факте понижения в ранжировании (наложении фильтра или забанивания) вам никто специально не сообщит и возможностей выхода из под фильтра вам никто не гарантирует.

Хотя, на самом деле, при корректном общение с «Платоном Щукиным» (так обычно подписываются операторы службы поддержки Яндекса) можно будет выяснить и причину понижения в выдаче, и решить проблему с выходом из под фильтра (полностью банят ресурс сейчас крайне редко). Правда, нервов и времени уйдет на это предостаточно.

Далее Яндекс говорит, что не обязан отчитываться за что именно вас забанили или понизили в выдаче, тем более, что со временем могут появляться все новые и новые методы спама, за которые можно будет угодить под фильтр. Но зато он приводит ссылку на весьма полезный документ — Чем отличается качественный сайт от некачественного с точки зрения Яндекса, который следует изучить со всем тщанием. Давайте вкратце пробежимся по его ключевым моментам, чтобы понимать чего не следует ни в коем случае делать в погоне за повышением релевантности.

Аффилиат-фильтр в Яндексе

Суть аффилиат-фильтра заключается в том, что из выдачи по определенным поисковым запросам исключаются сайты, принадлежащие одной и той же компании. Точнее, в выдаче остается только один из них. Нужен этот фильтр для более-менее честного распределения мест в Топ 10, чтобы исключить варианты, когда одна кампания занимает в выдаче более одного места по одному запросу.

На самом деле, идея «оккупации» Топа пришла в голову оптимизаторам уже довольно давно, и до того момента, когда появился фильтр за аффилирование, все это более или менее успешно реализовывалось. Т.е. создавалось несколько сайтов для продвижения по одной и той же группе запросов, которые на самом деле принадлежали одной компании и позволяли получать большую часть органического трафика, доступного в Яндексе по данному запросу (если удавалось занять весь Топ 3, 5 или даже 10).

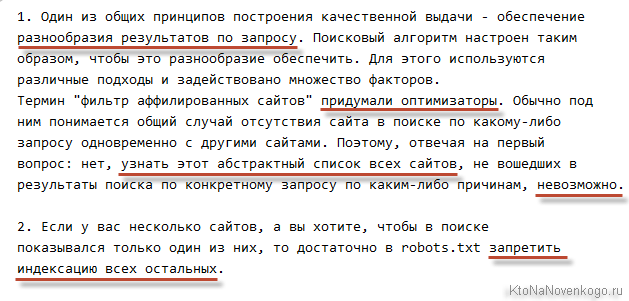

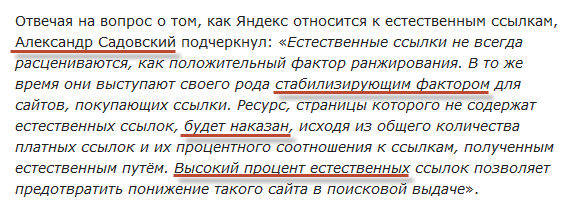

Каких-то сервисов, которые на сто процентов позволяют проверить аффилированность, на данный момент нет. В принципе, об этом писали и сами яндексоиды:

Однако, кое-что все-таки попробовать сделать можно. Помните, я писал про то, как искать в Яндексе и его язык поисковых запросов? Так вот, как раз некоторые из этих операторов и можно будет использовать.

Если у вас появились подозрения, что ваш сайт выпал из Топа по причине того, что Яндекс посчитал его аффилиатом какого-то другого ресурса, то можно будет это проверить. Для это вводите в поисковую строку такой вот запрос:

поисковый запрос ~~ site:урл предполагаемого аффилиата

Этим самым вы как бы исключаете из ранжирования тот ресурс, который Яндекс мог счесть аффилированным с вашим сайтом (подумать, что они принадлежат одной компании). Если это действительно так, то по такому вот хитрому запросу ваш ресурс должен будет показаться (примерно на тай же самой позиции). Возможно, что на момент прочтения этой статьи данный способ уже работать в полной мере не будет.

Поэтому оптимизаторам, подвигающимся на продвижении чужих сайтов, имеет смысл спрашивать у клиента о том, нет ли у него других сайтов с такими же контактными данными (принадлежащих этой же фирме), которые продвигают, например, другие Сеошники. В этом случае вы можете получить все симптомы аффилиат-фильтра даже не подозревая о высокой вероятности его наложения. Давайте, кстати, эти самые симптомы и рассмотрим:

- Резкое проседание вебсайта по всем запросам, по которым он был «виден» в Яндексе. Падение может происходить сразу на сотни позиций вниз (Яндекс не будет терпеть в Топе или близко к нему аффилиаты).

- Логично, что первый фактор приводит к резкому проседанию трафика, т.е. потока посетителей приходящих с Яндекса.

Поэтому, если вы даже не отслеживаете позиции своего сайта по продвигаемым запросам (например, в Топвизоре или SE Ranking), то проседание трафика вы уж точно заметите, что сподвигнет вас искать причину и вы не сможете не заметить провал по всем ранее занимаемым позициям.

Что же может служить для Яндекса предпосылкой к тому, чтобы наложить аффилиат-фильтр:

- В статье про работу асессоров Яндекса я упоминал, что одним из важных факторов для коммерческого сайта, который они проверяют, является контактная информация и ее полнота. Они могут даже выборочно проверять ее достоверность. Так вот, явным признаком аффилированности для Яндекса будет совпадение телефонов, адресов, положения на карте и других контактов. Вполне логично сделать предположения, что они принадлежат одной и той же кампании, а значит все кроме одного должны быть исключены из ранжирования.

- Когда вы покупаете доменное имя, то указываете свои контактные данные, которые в зависимости от настроек вашего регистратора можно будет скрыть из общего доступа (из WHOIS). Если данные не скрыли и при этом все домены были зарегистрированы на одно и то же лицо, то для Яндекса это будет очень серьезным поводом для наложения фильтра за аффилированность.

- Если даже вы закрыли личные данные в WHOIS IP, то поисковик может обратить внимание на использование одного и того же регистратора доменов или на то, что они зарегистрированы были примерно в одно и то же время.

- Очень часто все аффилиаты располагаются владельцами на одном и том же хостинге и зачастую даже имеют один и тот же IP-адрес, что опять же облегчает поисковой системе задачу их выявления. Понято, что так удобнее, но раскрыть вашу «маленькую хитрость» Яндексу тоже труда не составит.

- Не такими явными, но все же наводящими на подозрение признаками аффилированности, могут также являться:

- Использование на всех сайтах одинаковой структуры размещения данных, примерное совпадение номенклатуры товаров и услуг, а также использование похожих принципов их описания.

- Построение вебсайтов на одной и той же CMS (движке).

- Любые другие мелочи не очевидные для вас, но которые бросятся в глаза «машине», ибо вероятность такого совпадения будет не так уж и высока на фоне «средней температуре по больнице».

И ладно бы, если под этот фильтр попадали бы сайты только из одной и той же тематики, что было бы вполне логичным и понятным, ибо тут явно присутствует «злой умысел». Но зачастую под него попадают и ресурсы, принадлежащие одной и той же компании, но сделанные под разные тематики. Бывают же ведь разноплановые компании. Но им все равно приходится учитывать все выше сказанное и стараться не создавать повода для наложения афиллиат-фильтра «за здорово живешь».

Таким образом выход из-под этого фильтра для многих владельцев подобных разноплановых компаний будет достаточно мучительным. Поэтому во избежании наложения данного рода пессимизации имеет смысл под каждую из тематик делать сайты, которые Яндекс не должен будет каким-либо образом связать. Для этого нужно, чтобы:

- На каждом из них указывались уникальные контактные данные (телефоны, адреса, фамилии и т.п.).

- Размещение сайтов осуществлялось на разных хостингах или хотя бы на разных IP адресах.

- Регистрацию доменов желательно проводить на разных лиц, у разных регистраторов и с разнесение во времени.

- Использовать разные системы управления сайтами (движки) и постараться создавать разную структуру и навигационные решения.

Собственно, все те же самые советы пригодятся и тем, кто решит все-таки обмануть поисковую систему, пытаясь загнать в Топ по нужным запросам несколько ресурсов одной тематики. Но в этом случае критерий присвоения аффилированности, как мне кажется, будет использоваться более строгий, нежели для сайтов разных тематики. Опять же, ИМХО.

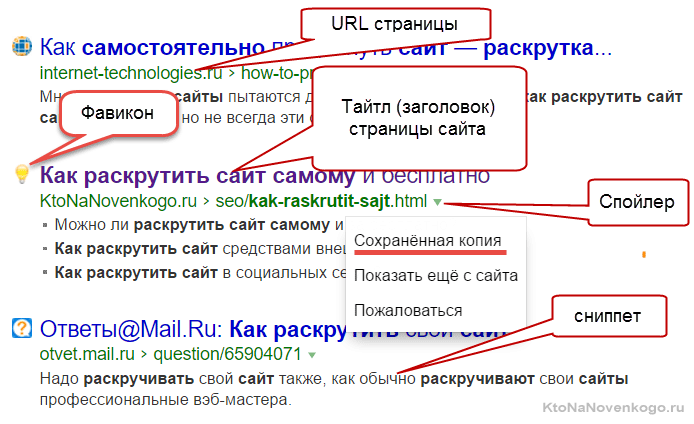

Фильтр за одинаковые сниппеты

Напомню, что сниппетами принято называть описания сайтов, которые поисковая система предоставляет в ответ на запрос пользователя. Текст сниппета поисковик выбирает по своему усмотрению, и для одной и той же страницы в выдачах по разным запросам он может отличаться. Текст берется, конечно же, из содержимого страницы (или из ее описания — Description).

Как я уже говорил, Яндекс, как и любая другая поисковая система, заботится о разнообразии и полноте своей выдачи. Среди основных инструментов этой борьбы можно выделить:

- Технологию «Спектр», которая формирует выдачу по неоднозначным запросам, когда четко нельзя понять, что именно хочет увидеть в ответ пользователь его набравший. Например, по запросу «продвижение сайтов» мой блог иногда пролезает в Топ 10 именно благодаря спектру, ибо пользователя может интересовать не только получение услуги продвижения, но и информация о том, как это делается.

- Также из выдачи стараются убрать предложения одинаковых товаров или услуг от одной и той же компании. Как вы поняли, это делает уже рассмотренный нами выше аффилиат-фильтр.

- Ну и, наконец, будет не очень здорово, если в выдаче (серпе, как его называют оптимизаторы) будут присутствовать сайты с одинаковым описанием (пусть и не аффилированные друг с другом). За это, соответственно, отвечает фильтр, накладываемый за одинаковые сниппеты.

Наиболее часто фильтр за одинаковые сниппеты накладывается при продвижении каких-то конкретных товаров (либо их позиций), описание которых было многими заимствовано из какого-то одного и того же источника (ну, чего там выдумывать, тем более, если товаров десятки или даже сотни тысяч). Т.е. фильтр накладывается тогда, когда неуникальное описание товара попадает в сниппет и при этом ваш сайт не признается Яндексом автором этого контента (то есть вас признают копипастером). Фактически, ваш сайты в выдаче склеивается с тем, кого поиск посчитал автором.

Иногда при просмотре такой выдачи можно увидеть внизу надпись, говорящую о том, что из результатов поиска исключены слишком похожие ответы. Чтобы увидеть полную выдачу без наложения этого фильтра, можно будет кликнуть на расположенную внизу надпись «Показать всё без исключения», либо можно прокрутить Урл в адресной строке вправо до конца и добавить там оператор «&rd=0»:

Основным симптомом наложения этого фильтра является потеря позиций по одному или нескольким запросам (чаще всего товарным). Что нужно сделать, чтобы выйти из-под фильтра за одинаковые сниппеты:

- Ищем в выдаче сайт, у которого с вашим совпадает сниппет (расклеивая их с помощью «&rd=0»), после чего пытаемся переписать свой сниппет. То есть ищем в тексте ту фразу, которую Яндекс выводит в выдаче, и переписываем ее, но так, чтобы она не потеряла свою привлекательность, ибо этот текст будет являться фактически вашим бесплатным объявлением, размещенным в Яндексе.

- На всякий случай и в мета-теге description заменяем неуникальное (или вообще отсутствующее) описание на что-то привлекательное с использованием ключевых слов, но ни в коем случае не спамное. По некоторым запросам сниппет может формироваться на основе дескрипшена, если он имеется.

- Если у вас интернет-магазин и вы используете не уникальные описания в карточках товаров (взятые с других сайтов), то обязательно озаботьтесь их уникализацией. Допишите, например, в начале карточки товара несколько уникальных пассажей с упоминанием тех ключевых слов, по которым вы планируете продвигаться. Часть из этого фрагмента может быть взята поисковиком для формирования сниппета.

- Если у вас имеется какое-то уникального торговое предложение, то упоминайте о нем в карточках товаров.

Возможно, что переписанные вами описания товаров не дадут ощутимого роста позиций (все зависит от вашего таланта копирайтера и оптимизатора), но это точно должно снизить вероятность попадания под фильтр за неуникальные сниппеты. Да, и, кстати, от фильтра Гугла под названием Панда это тоже может в некоторой степени защитить.

Санкциии Яндекса за взрослый контент

Поисковые системы стараются оберегать пользователей от фривольных сайтов при ответе на те запросы, которые однозначно не указывают на желание этого самого пользователя этот самый «взрослый» контент увидеть. То есть такие сайты в выдаче по обычным запросам просто напросто не участвуют.

Зачастую под этот фильтр попадают вполне себе белые и пушистые сайты, что называется «без злого умысла» (не имея как такового содержания «для взрослых» или ссылок на него ведущих). Например, такая информация может быть обнаружена поисковиками в рекламе, которая показывается на вашем ресурсе. Причем это может быть даже контекстная реклама. Довольно необычно было в свое время прочитать про чью-то переписку с Яндексом по поводу наложения этого фильтра, когда в результате выяснилось, что причиной стали рекламные блоки из сети самого же Яндекса (РСЯ).

В результате наложения этого фильтра ваш сайт может полностью пропасть из обычной выдачи (кроме «взрослых» запросов), что весьма печально. Основным признаком данного рода пессимизации может служить резкое падение трафика с Яндекса (в разы) при полоном сохранении трафика с Гугла.

Что же может стать причиной наложения фильтра за взрослый контент:

- Намеренное или ненамеренное (например, при недостаточно жесткой модерации постов на форуме или комментариев в блоге) размещение информации «для взрослых» на обычном сайте.

- «В зачет» идут и уже упомянутые рекламные блоки с фривольным содержимым или сомнительные партнерские программы размещенные на вашем ресурсе.

- А также оставленные вами или еще кем-то ссылки на сайты для взрослых. В принципе, для попадания под фильтр за взрослый контент достаточно будет и одной подобной ссылки. Особое внимание на это стоит обратить блогерам, ибо зачастую комментаторам разрешается оставлять Урл своего сайта, который вполне может подвести вас «под монастырь».

Методы выходы из под этого фильтра Яндекса вытекают из причин его вызывающих:

- Убрать все фривольное содержимое, если таковое имеется (статьи, изображения, комментарии, ссылки и т.п.).

- Убрать всю рекламу, в которой возможно появления такого рода контента. Можно и не убирать, а только лишь отключить «взрослую рекламу», как это, например, можно сделать в рекламной сети Яндекса.

- После того, как все это сделаете, нужно будет связаться с техподдержкой этой поисковой системы (читайте про это в статье про панель для вебмастеров в Яндексе) и дождаться ответа от нее. Если претензии по поводу взрослого контента все еще остаются, то попросите у Платона Щукина показать пример тех страниц или ссылок, которые вызывают нарекание у поисковика.

Если все нормально, то через пару апдейтов трафик с Яндекса у вас должен будет восстановиться.

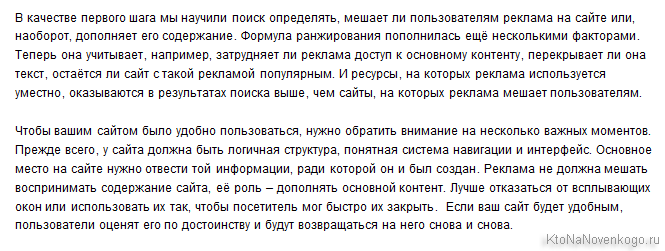

Пессимизация сайта за агрессивную рекламу

За чистоту выдачи Яндекс борется и на стороне самих сайтов, выкидывая или понижая в выдаче те из них, которые размещают попандеры, кликандеры, тизеры с шок-рекламой и прочие разновидности навязчиво-агрессивной рекламы, например, занимающей весь экран или блокирующей просмотр страницы. В результате посетитель вынужден ожидать или искать способ обойти навязанную ему рекламную информацию. По мнению поисковой системы, в Топе таким «редискам» не место, ибо они дискредитируют ее работу.

Признаком наложения такого фильтра может служить выпадение из Топ 10 по продвигаемым запросам (особливо по сильно конкурентным). Методы выхода в этом случае традиционные:

- Списаться с саппортом Яндекса и попытаться выяснить причину пессимизации.

- Если это все же окажется фильтр за агрессивную рекламу, то придется устранить причину — не использовать данный вид рекламы, пусть и в ущерб извлекаемого с сайта дохода. Упорствовать не имеет смысла, ибо похожий фильтр на вас может наложить и Гугл, тем самым полностью лишив вас трафика, а значит и дохода.

- Что касается тизерных сетей, то практически во всех из них можно отключить показ шокирующей рекламы, которую также с недавних пор невзлюбил Яндекс.

- Зачастую за агрессивную рекламу поисковики принимают всплывающее окно с предложением подписаться на рассылку или получить скидку (купон, промо-код). Чтобы минимизировать риски, лучше это предложение показывать пользователям в тот момент, когда они собираются уже уйти с вашего сайта (жмут на крестик в браузере). Делается это с помощью скрипта типа ComeBacker (камбекер), который позволяет «зацепить» процентов двадцать из казалось бы безвозвратно ушедших посетителей.

Как мне кажется, данный вид рекламы, несмотря не его высокую эффективность, трудно будет причислить к агрессивной. Из разряда «и волки сыты, и овцы целы».

- Написать в техподдержку Яндекса по результатам выполненных работ и подождать несколько апов, пока фильтр не снимется. Если этого не произойдет, то опять же обратиться в саппорт за разъяснениями (вежливо, доходчиво, без нервов и по сути вопроса).

Минусинск в Яндексе — за что накладывается фильтр и как это проверить

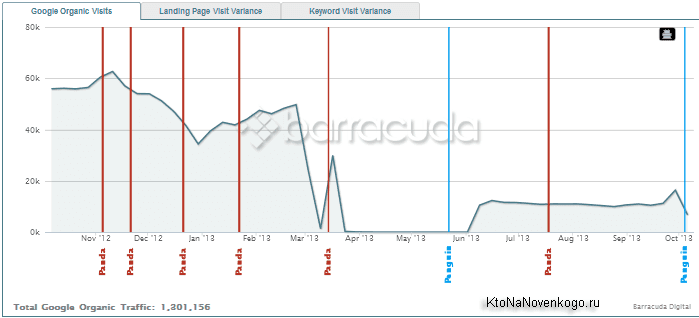

До некоторых пор пор Яндекс, зная о существовании у сайта обратных ссылок, полученных путем купли-продажи, ничего при этом особо не предпринимал в плане пессимизации. Гугл же со своим Пингвином свирепствует уже пару лет, а вот Яндекс лишь косо смотрел на SEO-ссылки. Однако, в середине мая 2015 все резко изменилось. За несколько дней, прошедших с этого момента, появились достоверные свидетельства того, что Минусинск действительно начал свою работу, и он таки реально выкашивает сайты из Топа.

При этом Минусинск не обращает особого внимания трастовый ли сайт перед ним, высокая ли у него посещаемость и насколько он большой, хорошо структурированный и просто замечательный. Ему на это (во всяком случае пока) по большому счету наплевать. В Топку летят чуть ли не все подряд, кто был не осторожен и не разборчив в наборе ссылочной массы. Да, пока что «счастливчиков», по уверению представителей Яндекса, не очень много (около полутысячи), но это, скорее всего, лишь «проба пера».

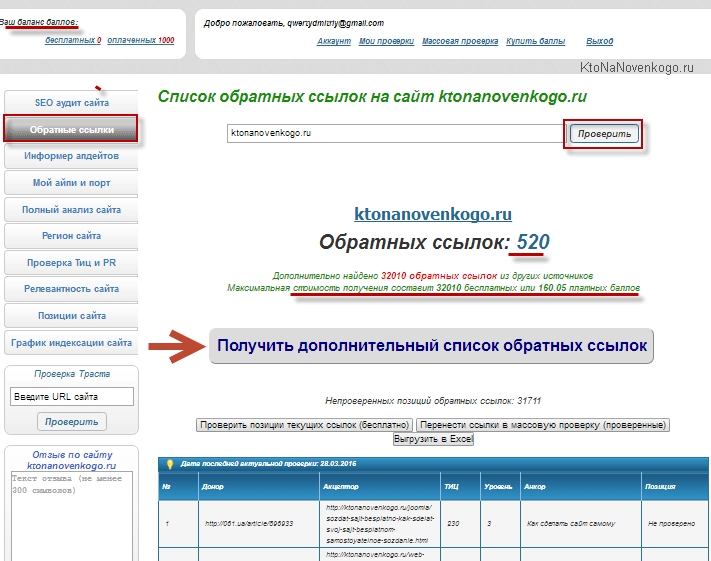

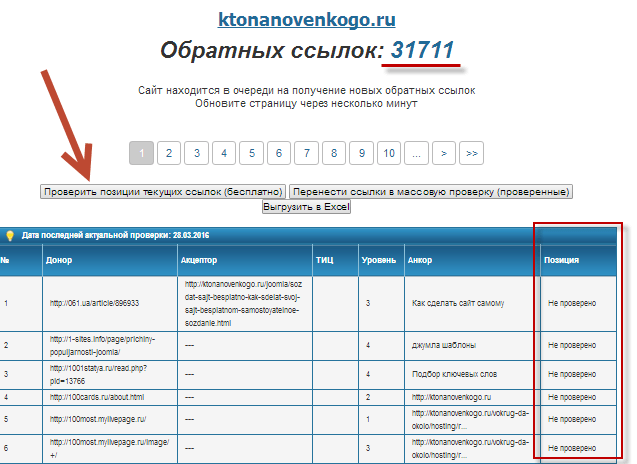

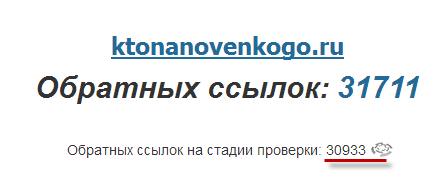

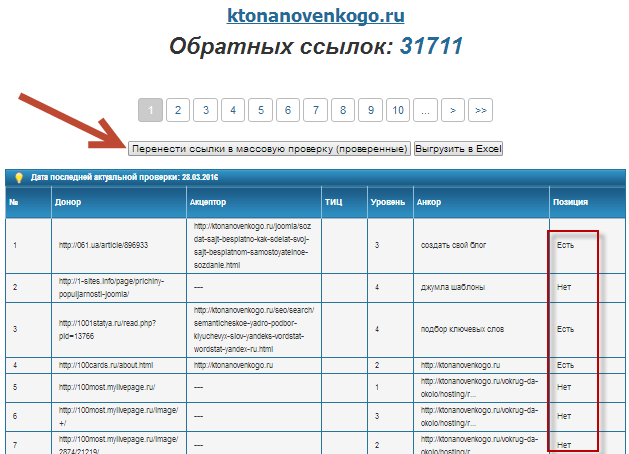

Критерии попадания под Минусинск и как это проверить

Первым, на что обратили внимание оптимизаторы при анализе статистических данных тех сайтов, которым не посчастливилось попасть под данный фильтр Яндекса, стало то, что число ссылающихся на них доменов (занимающихся продажей ссылок, что поисковики устанавливают довольно точно) близко к одной тысяче (точнее превышает десять сотен).

Это просто статистика, и к тому же все может поменяться при следующих итерациях совершенствования алгоритма, но пока следует ориентироваться именно на эту цифру. Стоит так же упомянуть, что санкции можно получить и с относительно небольшим числом входящих SEO-ссылок при условии, что они будут составлять значительную часть его ссылочного профиля.

Для верности лучше будет разделить данное число на два или даже на три. Если сайт имеет поддомены (например, для продвижения в разных регионах), то ссылки, ведущие на них, суммируют и увеличивают вероятность попадания под фильтр и домена, и поддоменов. Придется их разносить по отделенным сайтам. А что делать?

Таким образом, чтобы получить тот же эффект, придется закупать не все подряд ссылки, а искать качественных доноров, которые могут дать большой эффект и, возможно, заняться, прокачкой страниц-доноров для передачи ими большего динамического (анкорного) и статического веса (пейдранка). В общем, переходить к многоходовкам от прямолинейной закупки. ИМХО.

Как вы знаете, многие сайты, явно нарушающие рекомендации Яндекса, зачастую не несут наказания в силу своей высокой посещаемости и популярности в сети (им дозволено все из-за высокого авторитета у пользователей и поисковиков). Однако, Минусинск на посещаемость, пузомерки и размер (качество) сайтов на данный момент практически не обращает внимание. Главное — это число СЕО-ссылок проставленных на него, и если их тысячи, то все остальные достоинства сайта нивелируются.

При попадании сайта под этот фильтр, в Топе остается, как правило, очень небольшое число запросов, в связи с чем наблюдается сильное проседание трафика. Поэтому, если вы потеряли большую часть трафика с Яндекса примерно в середине мая этого года, то стоит начать думать в эту сторону. Кроме этого, есть довольно наглядный способ проверить попадание сайта под Минусинкс (пока работает, но, скорее всего, это временно).

Есть такое понятие, как витальный запрос. На такой запрос первым в выдаче всегда должен находиться сайт, отвечающий этому запросу. Например запрос «сайт ktonanovenkogo.ru», введенный в Яндекс, выдаст на первом месте ссылку на мой блог, ибо для него этот запрос является витальным. Так вот для сайтов, попавших под Минусинск, это правило на данным момент не работает (это несколько искажает и ухудшает выдачу, поэтому данное обстоятельство яндексоиды могут исправить, но пока вроде бы все работает).

Итак, если ваш сайт потерял почти весь трафик с Яндекса в середине мая этого года, то:

- Проверьте для начала его индексацию, введя в поисковую строку запрос с параметром поиска только по вашему сайту вида:

site:ktonanovenkogo.ru

Если страниц в индексе столько же, сколько было и раньше, то это не АГС, который тоже зачастую приводит к полной потере трафика с Яндекса. - Проверьте позицию вашего сайта по витальному запросу, например такому:

сайт ktonanovenkogo.ru

У «здорового» пациента будет все в порядке, а вот у больного Минусинском на первом месте будет что-то другое. Сам же исследуемый сайт, скорее всего, найдется где-нибудь во втором-третьем десятке. Это несколько портит выдачу Яндекса, но пока они это не поправили и таким образом можно довольно четко диагностировать наложение данного фильтра.

Как избежать фильтра и что делать при попадании под него

Ну, как уже говорилось выше, нужно постараться сократить количество SEO-ссылок (на данном этапе развития алгоритма Минусинска речь идет, скорее всего, лишь о ссылках с повременной оплатой) до нескольких сотен. Имеется в виду несколько сотен ссылающихся доменов, ибо бэклинки могут в большом количестве идти и с одного сайта.

Чтобы сайт не просел следует пересмотреть подход к покупке ссылок и акцентироваться на их «силу и мощь», а не на их большое количество без оглядки на качество. Кроме ссылок обратите внимание на такую вещь, как крауд-маркетинг, который пришел к нам из буржунета, где на горло ссылочной песни наступили чуть раньше. Про то, что сам сайт должен быть «конфеткой», я уже и не говорю, ибо и раньше без этого в Топе делать было практически нечего.

Если же ваш сайт уже попал под Минусинск, то из этой ситуации по традиции может быть два выхода:

- Плыть по течению

- Можно привести сайт в соответствие с требованиями Яндекса, т.е. снизить число ссылающихся Сео-доменов до нескольких сотен.

- Дождаться того момента, когда Яндекс переиндексирует страницы-доноры, с которых вы сняли ссылки. Отслеживать обратные ссылки лучше всего через Яндекс Вебмастер, чтобы не бежать впереди паровоза.

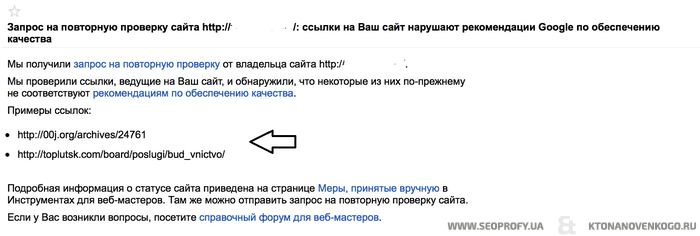

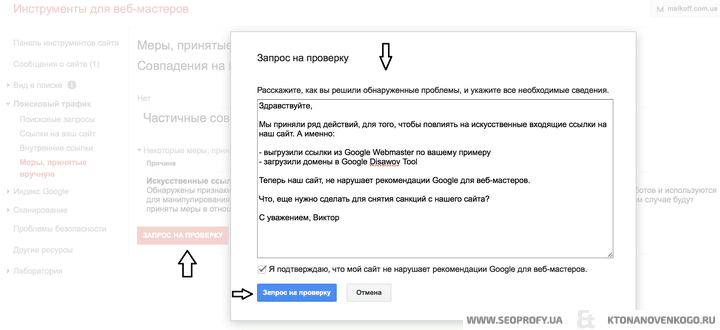

- Отписаться в техподдержку поисковика, чтобы они обратили внимание на ваше осознание вины и по возможности поспособствовали скорейшему снятию фильтра.

- Попробовать изменить судьбу как это делали, например, в период наложения уже существующих ранее фильтров в Яндексе

- Перенести сайт на новый домен

- Перекинуть со старого на новый сайт постраничный 301-редирект

- Дождаться его полной индексации и появлении позиций в Топе (трафика)

- Снять редирект и убрать из сети первоначальный сайт (на зафильтрованном домене), чтобы по редиректу не переполз на новый сайт и Минусинск

- Разрабатывать и осуществлять стратегию продвижения нового сайта уже с учетом всего выше сказанного

Правда никакой гарантии на быстрый выход из под Минусинска ни первый, ни второй варианты не дают, но делать-то все равно что-то надо. В период же «СЕО безрыбья» придется уповать на Гугл Адвордс и Яндекс Директ (на что частично и был нацелен Минусинск). ИМХО.

P.S. 27 мая похоже, что произошла очередная итерация алгоритма и по заверениям Яндекса под Минусинск попала уже тысяча сайтов (плюс пять сотен, что попали под этот фильтр еще в середине мая). Похоже, что фильтр набирает силу (прям, как торнадо).

P.S.2 На блоге Деваки (Сергея Кокшарова) опубликованы Результаты исследования алгоритма «Минусинск». Весьма любопытная информация.

Что мы имеем на сегодняшний день?

В прошлой статье я упоминал, что многие вебмастера и оптимизаторы просто не успели за отведенный Яндексом месяц (15 апреля его представители сделали «последнее китайское предупреждение» и разослали около десяти тысяч уведомлений) снять покупные ссылки (лишь треть из этих сайтов начали действительно снижать покупную ссылочную массу).

Тут правда нужно упомянуть, что, например, в случае вечных ссылок это вообще выливается в довольно-таки серьезную проблему. Однако, если такой проект не попал под этот фильтр, то, как не странно, есть примеры роста трафика и позиций именно за счет снятия ссылок, что звучит несколько странно. Но есть и обратные примеры.

Как я уже упоминал, Яндекс преследует в ведении Минусинска определенную цель — заставить вебмастеров перенаправить усилия и денежные потоки с покупки ссылок на улучшение своих проектов (юзабилити, качество, полноту и другие факторы ранжирования коммерческих сайтов), ну и, конечно же, желает увеличить доходы с размещения контекстной рекламы в своей выдаче и рекламной сети (что из этого первично, пусть каждый решает для себя сам).

Минусинск довольно жестко обходится с теми ресурсами, которые под него попали — трафик с Яндекса пропадает практически совсем (кроме запросов, которые были подмешаны в выдачу по технологии Спектр, но сейчас, возможно, и это тоже почикали). Такой жесткий подход представители поисковика объясняют тем, что за отведенный месяц были сняты лишь около десяти процентов всех покупных ссылок, что не очень-то и много.

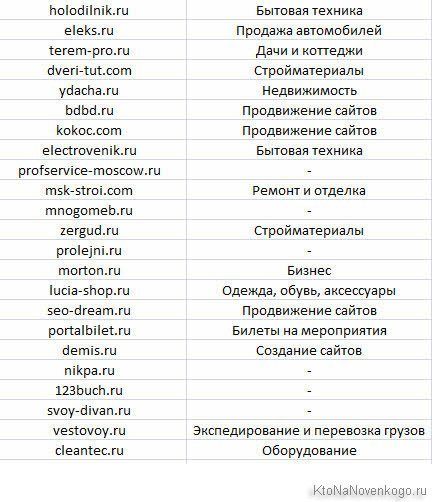

Под фильтр в первую волну попали многие лидеры в своих нишах (холодильник.ру, мортон, bdbd, элекс.ру и т.п.). В основном это очень старые сайты, которые продвигались за счет большого количества платных ссылок.

Всего пострадало около пяти сотен сайтов (а может быть и больше, ибо выдача изменилась достаточно серьезно). Основным негативным фактором при этом было то, что эти сайты давно и упорно наращивали огромную покупную ссылочную массу (с большим количеством ГС в качестве доноров). Фактически Яндекс де-факто (а не только на словах) объявил войну покупным ссылкам. Да и первые достигнутые результаты впечатляют — доля СЕО-ссылок в общем по рунету сократилась на одну пятую по сравнению с апрелем этого года.

Следующие волны Минусинска уже не будут сопровождаться рассылкой предупреждений, поэтому вебмастера и оптимизаторы поставлены в довольно-таки сложную ситуацию, когда нужно решать вопрос о снятии или оставлении имеющейся ссылочной массы. Подогревает ситуацию еще и тот факт, что пока не один из сайтов из под этого фильтра не вышел (первых ласточек стоит ждать через месяц или два, наверное).

Несколько важных, на мой взгляд, моментов:

- На вопросы владельцев сайтов, попавших под Минусинск, Платон Щукин обычно отвечает, что сайт действительно находится под этим фильтром, и надо снять все покупные ссылки для выхода из под него и дождаться, когда это все увидит Яндекс (но можно будет и отписать в их техподдержку по факту). Хотя, можно и самостоятельно диагностировать данный вид пессимизации способом, описанным в первой публикации.

- Мое предположение о том, что от данного фильтра можно убежать переносом сайта на другое доменное имя и проставлением на какое-то время 301 редиректа, скорее всего, было ошибочным.

- К сожалению, инструмента подобного Disavow links Яндекс создавать и использовать не планирует, что несколько усложняет задачу оптимизаторам, ибо придется в реале снимать ссылки, а не просто сообщать поисковику о тех из них, которые не стоит учитывать. Нужно понимать, что снятие ссылок повлияет и на позиции сайта в Гугле.

- Пессимизации сейчас подвергаются не все сайты рунета сразу, а как бы пластами. Таким образом Яндекс имеет возможность не сильно подпортить выдачу возможными перегибами, но зато все остальные участники СЕО-гонки получают четкий сигнал (видя страдания тех, кому не повезло оказаться в первых рядах проигравших), что нужно не надеяться на авось и приводить свой ссылочный профиль в порядок.

- Судя по количеству разосланных предупреждений (около девяти тысяч), как минимум такое количество ресурсов может попасть под этот фильтр в очередные волны пессимизации. Это довольно много, ибо в основном рассылка велась по сайтам, находящимся в Топе в крупных нишах бизнеса. Возможно, что более мелких игроков просто не удосужились предупредить или, возможно, что они еще не набрали критическую массу плохих покупных ссылок. Со временем планка может опускаться и список кандидатов на Минусинск может быть расширен.

- Какие ссылки можно оставлять? Яндекс говорит, что те, которые полезны пользователям. Собственно, подробности читайте в статье — Как ссылки сейчас учитываются поисковиками? Отличие сегодняшней ситуации в том, что раньше бесполезные пользователям ссылки просто не работали, а сейчас за это можно лишиться всего трафика с самой популярной в рунете поисковой системы.

Факты и домыслы на тему Минусинска

Также хочу еще раз остановиться на факторах, на которые ориентируется Минусинск при своей работе:

- В первую очередь оценивается возраст имеющихся в профиле ссылок (по дате их индексации). Дело в том, что алгоритм должен четко отличать накрутку вашего ссылочного профиля нечистыми на руку конкурентами и вашими собственными усилиями по покупке ссылок. Понятно, что конкуренты долго держать ссылки не будут, ибо это накладно, а значит для их отсева достаточно будет рассматривать бэклинки, которые были размещены уже достаточно давно (более года, ориентировочно).

- Далее оценивается количество и качество бэклинков. Если будет много спамных ссылок (по отношению к естественным), то такой профиль будет призван дефектным с последующим наложением фильтра. Среди сайтов, уже попавших под Минусинск, спаммных ссылок в каждом профиле было как минимум более нескольких сотен, а чаще даже более нескольких тысяч.

- Алгоритм этот имеет, естественно, механизмы обратной связи (в том числе, наверное, даже и с помощью асессорского корпуса), а значит при очередной его волне может измениться средний порог по возрасту и количеству ссылок, достаточному для наложению фильтра. Все это будет оттачиваться и доводиться до совершенства.

- После пессимизации сайт проседает на десяток другой позиций вниз по всем запросам, что автоматически приводит практически к полной потере трафика (как минимум он просядет на порядок) с самого значимого для большинства коммерческих сайтов поисковика. Именно это и является главным калибром, которым Яндекс сейчас пока еще выборочно палит по биржам ссылок и сайтам, которые с помощью них продвигались.

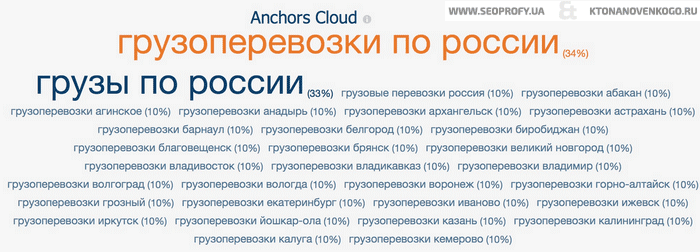

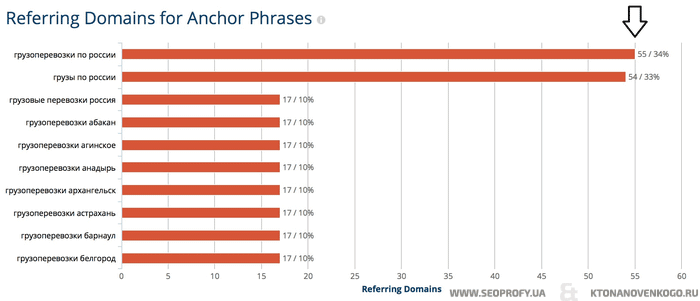

Все сайты, находящиеся сейчас под Минусинском (которые отловили оптимизаторы), были всесторонне изучены. Анализировался анкор лист, качество сайтов доноров, разнообразие ссылочной массы и т.д. Некоторые крупные игроки рынка, имеющие свои огромные массивы данных, на основе которых можно делать выборки (например, все тот же Мегаиндекс) высказали несколько предположений, которые можно свести к следующему:

- Яндекс мог создать для себя черный список доноров (которые продают ссылки в промышленных масштабах), и при наличии в ссылочном профиле большого числа бэклинков с них, сайт может быть пессимизирован. Это всего лишь предположение, но на имеющейся у Мегаиндекса базе он выкатил даже «черный список доноров», с которыми ни в коем случае не стоит иметь дело.

- Если опять же на том же Мегаиндексе можно посмотреть аналитику по входящим ссылкам (прежде, чем переходить по этой ссылке , зарегистрируйтесь или авторизуйтесь в Мегаиндексе) для попавших под фильтр сайтов (она там в графическом виде очень даже хорошо воспринимается), то видно, что многих из них не спасли даже попытки сделать свой ссылочный профиль наиболее близким к естественному, например, с помощью добавления большого числа безанкорных ссылок. Яндекс такой обман, видимо, довольно легко распознает.

- Судя по количеству имеющейся у находящихся под Минусинском сайтов ссылочной массы (в большинстве своем свыше тысячи бэков), можно сделать вывод, что копилась она не один год и имеет приличный возраст. Кроме этого, чуть ли не девяносто процентов из всех имеющихся беклинков были закуплены в биржах (косвенно об этом можно судить по низкому среднему значению Тиц всех имеющихся доноров, но не всегда это будет объективно). И при этом среди доноров много гигантских линкопомоек.

- У многих из зафильтрованных ресурсов можно также наблюдать сильный уклон анкор-листов в сторону их коммерциализации (мало разбавлений).

- Вполне возможно, что с приходом очередных волн Минусинска требования к ссылочной массе будут еще больше ужесточаться.

- Завалить конкурента, как вы уже, наверное, поняли, с помощью покупки на него тонны ГС бэклинков не получится, в силу того, что алгоритм прежде всего учитывает возраст ссылок (на данный момент вряд ли учитываются бэки, проставленные менее года назад). Держать ссылки в течении года, пожалуй, ни один конкурент себе позволить не сможет (да и конкурент может Яндексу пожаловаться на несанкционированный рост ссылочной массы).

Как жить оптимизатору в эру нового алгоритма Яндекса

- Начать очень трепетно относиться к ссылочному профилю сайтов — качество ссылок должно превалировать над их количеством. За количество сейчас можно очень жестоко поплатиться.

- Продвижение сейчас, наверное, стоит начинать с покупки очень трастовых (с высоким Тицем), тематичных (например, с отраслевых каталогов) и потенциально кликабельных ссылок. Доноры при этом не должны торговать ссылками направо и налево, а также желательно не должны участвовать в ссылочных биржах. Возможно, что они будут очень дороги (например, Яндекс Каталог) или их получение будет очень трудоемко (поиск подходящих каталогов, справочников, порталов, форумов), но их влияние сейчас является определяющим.

- Если вы изначально зададитесь целью построить естественный ссылочный профиль, то никакие санкции вам будут не страшны. Про то, как это сделать, я думаю написать отдельную статью в ближайшее время.

- Отдельно подчеркну один из признаков близкого к естественному профиля — достаточно высокая разбавка анкоров, и как минимум треть от общей массы ссылок (это особливо касается молодых сайтов) должна быть безанкорной.

- Сначала следует покупать (получать бесплатно) бэклинки исключительно только с сайтов из вашей тематики и отдавать предпочтения тем вариантам, где вероятность клика по вашей ссылке выше (с посещаемых страниц популярных ресурсов). Общее качество донора тоже очень важно, но его следует рассматривать именно в привязке к тематике.

- Все вышесказанное будет бесполезно, если вы не привели сайт в соответствие со всеми требования поисковых систем (читайте про пять основных ошибок при продвижение коммерческого сайта). Для этого нужно будет:

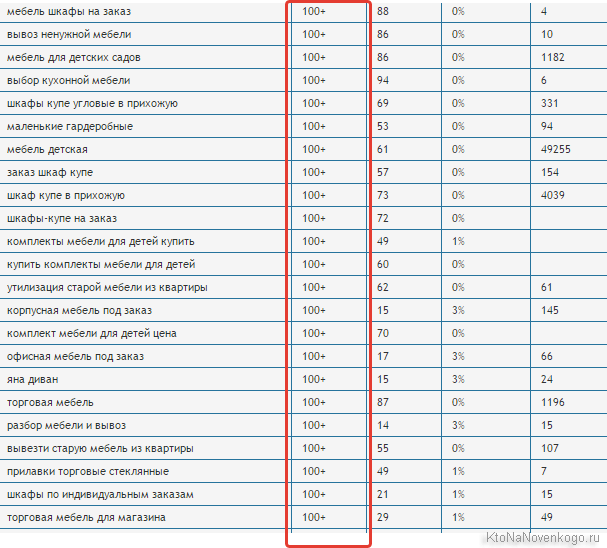

- Собрать полное семантическое ядро, а не несколько сотен лежащих на поверхности запросов. Чем больше будет охват (полнота информации в данной нише), тем лучше будет отношение поисковиков и выше трафик с них (длинный хвост запросов обеспечивает быстрое попадание в Топ и высокую конверсию, а значит и хорошие поведенческие характеристики).

- Сгруппировать данные запросы по страницам с использованием принципа, когда одна страница сайта должна решать одну проблему пользователя, с которой он обратился к поисковой системе своим запросом. Запросов же при этом на одной странице может быть использовано несколько, ибо одну и ту же проблему можно облечь в разные слова.

- Написать контент для всех страниц (грамотно составить техзадание для копирайтеров) с правильной оптимизацией их под намеченные запросы.

- Скомпоновать полученные горы контента на сайте (разделы, навигация и т.п.) и провести аудит удобства его использования для определения направлений для доработки юзабилити. Также необходимо будет провести технический аудит сайта (типа описанного в статьях про зеркала и дубли, а еще про Http ответы и редиректы).

- И только после этого начать работу над построением близкого к естественному ссылочного профиля. Начало работы с ссылками раньше выполнения описанных выше пунктов можно сравнить с тем, чтобы начать расставлять книги не собрав предварительно книжный шкаф.

- По мере развития проекта и роста трафика, следует активно использовать системы аналитики для повышения конверсии и улучшения юзабилити. Процесс этот никогда не следует считать завершенным, ибо остановившись вы фактически начнете откатываться назад.

Печально-банальные выводы

Правда состоит в том, что сайты, продвигаемые по описанной выше схеме, очень редко встречаются, ибо за простотой шагов стоят очень большие трудозатраты. Однако, такому ресурсу уже будут не страшны никакие фильтры поисковых систем, ибо он строился с правильными приоритетами и без «финтов ушами», т.е. с ориентиром на удобство конечного пользователя.

Тут воплощается в жизнь избитая истина — делайте сайты для людей и они к вам потянутся, а поисковики ничего не будут иметь против (только за). И это будет работать всегда, во всяком случае в обозримом будущем. Времена из серии «дешево и сердито» завершились, как бы нам и не хотелось этого признавать. ИМХО.

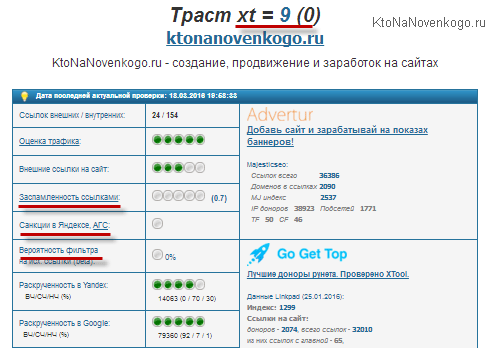

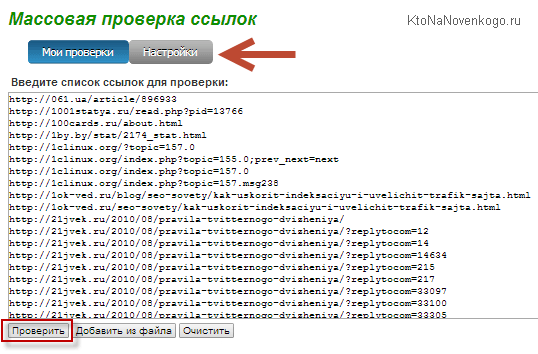

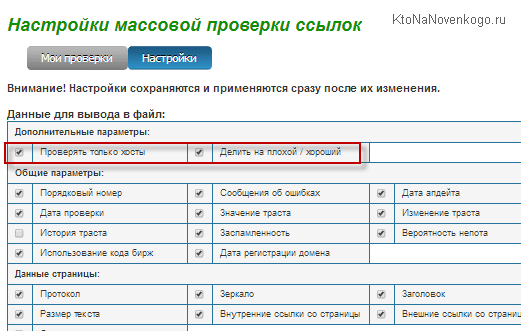

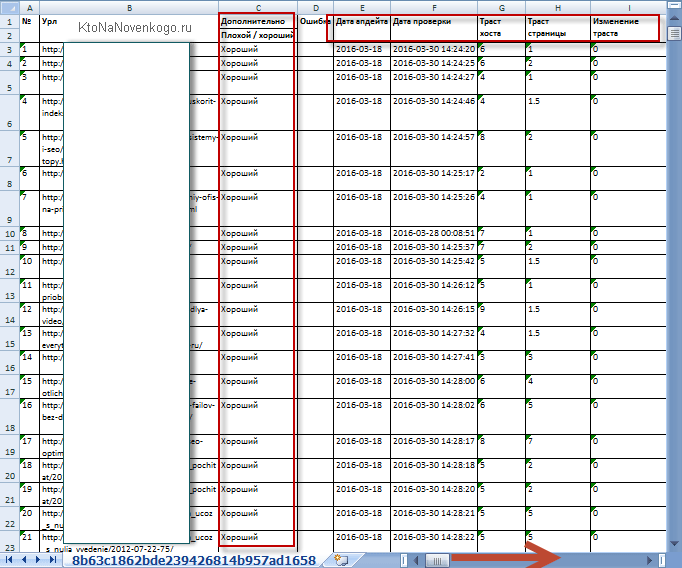

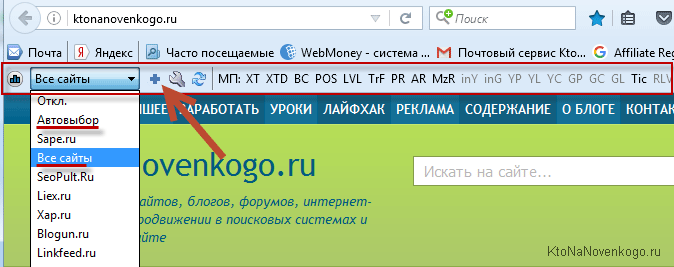

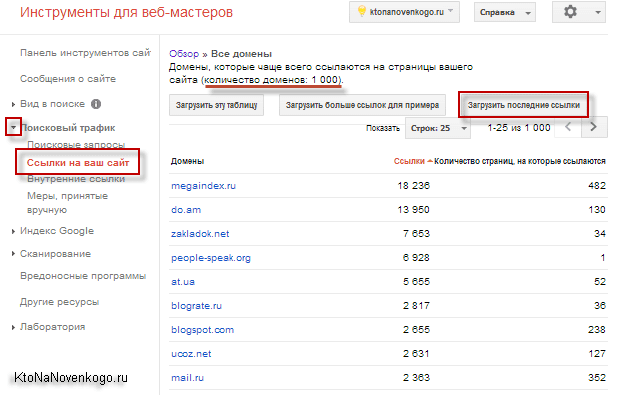

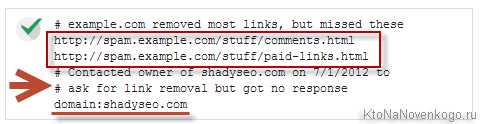

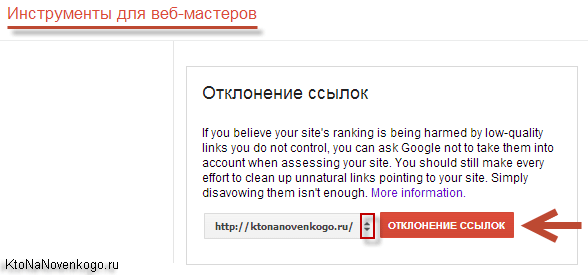

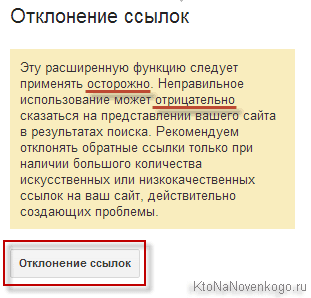

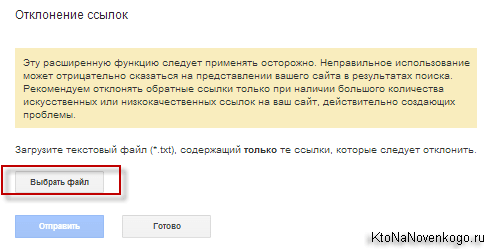

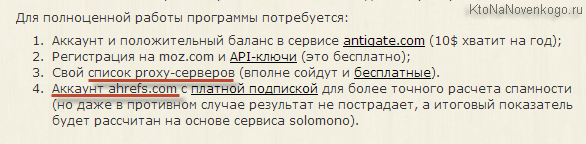

Как удалять плохие ссылки на сайт с помощью XTool в эпоху Минусинска